技術探勘

- Advertisement -

新興應用前仆後繼 GDDR/HBM高效能記憶體潛力大

在今日的資料經濟中,每天有極大量的資訊產生、被儲存和處理。資料產出的深入洞察可創造驚人的價值,並更進一步提升效率。記憶體科技的創新正是讓資料洞察從無到有的關鍵。本文旨在探討今日與未來市場對於高效能記憶體的需求,使讀者了解現階段的市場挑戰,以及高效能記憶體對於各種資料密集與頻寬密集型的應用均不可或缺的原因。

高效能記憶體市場趨勢/流變

AI、機器學習、深度學習、無人自駕車、高效能運算、虛擬實境、擴增實境等應用,使下一代遊戲不只是熱門詞彙。

這些應用的使用量大幅成長,皆需用到非常大量的資料—這些資料不僅量大,還必須被快速和重複分析,而占用極大的系統頻寬(圖1)。筆者相信,2020年是決定下一代高效能記憶體技術發展的關鍵年。

圖1 各領域針對資料使用量不斷上升

打造高效能記憶體系統

雖然專用於繪圖卡快速渲染之同步動態(Synchronous Dynamic)繪圖用雙倍資料傳輸率(Graphics Double Data Rate, GDDR)記憶體技術已發展多年,但本文僅探討2008年GDDR5出現後的進展。當年,市場需要以已知的設計方法和原料,以及可負擔的封裝方式,來提高記憶體的資料傳輸速率。GDDR5從512Mb開始、成長到8Gb的密度,最後達到每引腳8Gbps的最高資料傳輸效能。若要計算系統頻寬的話,以典型的繪圖卡配置(8顆元件、32位元介面)而言,每引腳傳輸速率8Gbps的GDDR5可提供8GB的訊框緩衝(Frame Buffer)與256GBps的系統頻寬。市場雖一度可以接受這樣的效能,但不久後便追求進一步提高頻寬。

2015年美光(Micron)與NVIDIA合作,在GDDR5X中導入JEDEC的創新標準,將每引腳最高的資料傳輸率增至12Gbps。之後的兩年期間,GDDR5X稱霸高階繪圖卡市場。例如NVIDIA Titan X(32位元介面、12顆元件、每引腳資料傳輸率11.4Gbps)的系統頻寬便達到547GBps。

或許,GDDR5X最重要的成果是,它奠定了GDDR6的框架。GDDR6於2018年秋季問世後,效能立刻在市場上顯現。當NVIDIA於2018年、AMD於2019年推出8Gb GDDR6時,美光為兩家公司的產品發布夥伴,滿足市場對高效能的需求。GDDR6現仍在產品預期生命週期的相對早期階段,目前,每引腳最大資料傳輸率為16Gbps。使用GDDR6的系統最高頻寬預計可達768GBps(32位元介面、12個元件、16Gbps的每引腳資料傳輸速率)。GDDR6不只是高效能的解決方案,也是適用於多種不同應用的成本優化方案(表1)。

講到高效能記憶體,就不免提到高頻寬記憶體(HBM)。HBM不但與運算元件緊密整合,還能同時降低功耗和拉高頻寬,填補記憶體方案的缺口。HBM透過堆疊記憶體元件提高密度,並以較低時脈達成較高的I/O數,進而提供高頻寬,並具備較低功耗。HBM是一種強大的高效能記憶體,但由於產品本身的複雜性,也是成本相對較高的方案,因此HBM鎖定需較高頻寬,且成本敏感度較低的應用(圖2)。

圖2 高頻寬記憶體運用堆疊的記憶體元件,達成高密度與高I/O數

GDDR與HBM是高效能記憶體市場中的關鍵產品,接著探討主要的市場趨勢。

新市場趨勢與應用層出不窮

在列舉高效能記憶體的應用時,遊戲(Gaming)通常是最先浮現腦海的應用。雖然遊戲的重要性不容小覷,但有些新興的市場趨勢與應用也讓繪圖產業的需求水漲船高(圖3)。

圖3 新興的市場趨勢與應用也讓繪圖產業的需求水漲船高

人工智慧/機器學習與GPU

繪圖處理器(GPU)過去多半僅用於遊戲領域。但是,隨著AI在各產業區塊的爆炸性發展,GPU已是創造價值和效率的利器。GPU普遍都需要高效能的記憶體。機器學習與深度學習訓練所用的演算法需執行複雜的數學及統計運算,而GPU已被證明可較CPU更快解決這些繁雜的計算。在討論AI時,必須區別推論(Inference)和訓練(Training)兩種不同的需求。AI訓練是運算非常密集的工作,系統頻寬越高越好。AI推論則較常見,對頻寬的要求低於AI訓練。訓練與推論都是未來不可或缺的一部分。兩者合併運用下,可創造出高品質的神經網路。GPU及其尖端記憶體正被應用於AI、機器學習和深度學習上,讓這些應用以人類所不及的準確度,解決更多真實世界的難題。

高解析度影片

下一個驅動高效能記憶體成長的是4K/8K內容。高階遊戲不斷推動繪圖技術在高解析度與回應速度上的創新突破(零延遲/零緩衝)。今日許多頂級的遊戲設備均搭載4K解析度,未來更將達到8K或更高解析度。專業的遊戲玩家常同時使用多台顯示器,其中不乏4K+的螢幕(因為工作負載高,對於繪圖卡與大訊框緩衝區的需求也會增加)。

由於影像解析度增加,視訊渲染未來仍需大訊框緩衝區與高頻寬。隨著媒體內容與遊戲的串流應用在全球日益普及,資料中心的資料處理能力也需日漸提升。

遊戲創新

雲端遊戲的運作仰仗資料中心。那些資料中心內的伺服器多搭載GPU,以優化效率。Google Stadia、NVIDIA GeForceNow、PlayStation Now與Microsoft Project xCloud都是近期出爐的一些新型雲端遊戲平台。雲端遊戲預計將快速成長,並持續推動創新。光線追蹤(Ray Tracing)是視覺繪圖領域中夢寐以求的技術。從光源追蹤光線及設計出逼真照明環境的能力,一直是繪圖產業在過去20多年間努力的目標。在NVIDIA和AMD最新的繪圖卡產品,以及即將上市的PlayStation 5與Xbox Series X遊戲機上,這種渲染技術終於落地。

PC遊戲正驅策遊戲市場中頂級規格的發展。由於PC可每年或更頻繁地更新硬體,專業玩家普遍偏愛PC遊戲。PC遊戲持續帶動繪圖功能強化(4K/8K、光線追蹤與可變速率著色),以及對於最高回應時間(最低緩衝/延遲時間)的需求。如上面關於高解析度影像的討論,專業遊戲玩家有時會同時使用多台最高規格的顯示器;在這樣的配置下,玩家需不斷更新系統,才能保持競爭力。

為了達到最佳效能,玩家傾向選用內建不只一張繪圖卡、而是搭載多張平行運作繪圖卡的遊戲設備。

AR/VR

無論在PC遊戲或主機遊戲的世界裡,虛擬實境(VR)都已是許多不同遊戲的熱門選項。從早期較簡單的型態開始,VR繪圖技術和功能現正突飛猛進,並滲透至諸多新領域中。隨著品質精進,遊戲將繼續以健康的速度成長,但更亮眼的成長將來自一些令人振奮的新領域。

在醫療產業中,VR和擴增實境(AR)都可望成為教育訓練的利器。目前,已經有些有趣的應用(運用AR)將虛擬物件融入真實環境,以輔助醫療教學。如美光繪圖卡解決方案不局限於遊戲領域,將觸角延伸到垂直產業,包括專業繪圖、高效能運算、車載應用與網路等。

建築、工程與建造是VR與AR顯而易見的下一波灘頭堡。對許多領域來說,能夠在實地參訪或建構實體建物前,先虛擬地「看到」或甚至遊覽某地或建築、並了解物件將如何與所在環境互動,前景都令人倍感期待;教育領域的VR與AR的應用可望大幅成長。與醫療訓練一樣,講師和專家在教學中也可運用虛擬物件、提供虛擬的範例和與虛擬元素互動。

高階AR與VR頭戴裝置需搭配強大的PC和繪圖卡,才能達到最高設備規格。HTC Vive Pro最低規格的顯卡是NVIDIA GeForce GTX 1060或AMD...

整合多階/類比記憶體運算 AI邊緣功耗難題迎刃而解

雖然使用者可以享受到這些AI應用帶來的益處,但同時仍有隱私、功耗、延遲和成本等諸多疑慮,這些疑慮便成為AI 應用的挑戰。如果有一個能夠從資料來源,執行部分/全部運算(推論)的本地處理引擎,那麼這些問題即可迎刃而解。傳統數位神經網路的記憶體存在功耗瓶頸,難以實現這一目標。為了解決此問題,可以將多階記憶體與類比記憶體內運算方法結合使用,使處理引擎滿足更低的毫瓦級(mW)到微瓦級(μW)功率要求,進而在網路邊緣執行AI推論。

雲端AI面臨隱私/功耗/延遲挑戰

如果透過雲端引擎為AI應用提供服務,使用者必須主動/被動上傳一些資料到雲端,運算引擎則在雲端處理資料並提供預測,然後將預測結果發送給終端用戶使用。以下概述資料處理過程面臨的挑戰(圖1):

1.隱私問題:對於Always-on、Always-aware設備,個人資料或機密資訊在上傳期間或在資料中心保存期限期間可能遭受濫用的風險。

2.不必要的功耗:如果每個資料位元都傳輸到雲端,則硬體、無線電、傳輸裝置以及雲端中不必要的運算都會消耗電能。

3.小批量推論的延遲:如果資料來自邊緣裝置,有時至少需要一秒才能收到雲端系統的回應。當延遲超過100毫秒時,人們便有明顯感知,造成不佳的用戶體驗。

4.資料經濟需要創造價值:感測器隨處可見且價格低廉,能夠蒐集大量資料,但是如果每筆資料都上傳到雲端進行處理的效益不高。

圖1 從邊緣到雲端的資料傳輸

要使用本地處理引擎解決這些挑戰,首先必須針對目標使用案例,利用指定資料集合對執行推論運算的神經網路進行訓練。這通常需要高效能運算和記憶體資源,以及浮點運算。因此,機器學習解決方案的訓練部分仍需在公共、私有雲或本地GPU、CPU和FPGA Farm上實現,同時結合資料集合來生成最佳神經網路模型。神經網路模型的推論運算不需要反向傳播,因此在該模型準備就緒之後,可利用小型運算引擎針對本地硬體進行深度優化。推論引擎通常需要大量乘積累加運算(Multiply Accumulate, MAC)引擎,隨後是啟動層,例如修正線性單元(ReLU)、Sigmoid函數或雙曲正切函數,具體取決於神經網路模型複雜度,以及各層之間的池化層。

大多數神經網路模型需要大量MAC運算。例如,即使是相對較小的「1.0 MobileNet-224」模型,也有420萬個參數(權重),執行一次推論需要多達5.69億次的MAC運算。此類模型中的大多數都由MAC運算主導,因此這裡的重點是機器學習計算的運算部分,同時還要尋找機會來建立更好的解決方案。圖2為一個簡單的完全連接型兩層網路。輸入神經元(資料)透過第一層權重處理。第一層的輸出神經元透過第二層權重處理,並提供預測,例如模型能否在指定影像中找到貓臉 。

圖2 完全連接的兩層神經網路

這些神經網路模型使用「點積」運算計算每層中的每個神經元,如下面的公式所示:

Yi=∑i Wi Xi 〗

(為簡單起見,公式中省略了「偏差」項)。

在數位神經網路中,權重和輸入資料儲存在DRAM/SRAM中。權重和輸入資料需要移至某個MAC引擎旁以進行推論。根據圖3,採用這種方法後,大部分功耗都源自於獲取模型參數以及將資料登錄到實際發生MAC運算的ALU。從能量角度來看,使用數位邏輯閘的典型MAC運算消耗約250fJ的能量,但在資料傳輸期間消耗的能量超過運算本身兩個數量級,達到50皮焦(pJ)到100pJ的範圍。實際上,很多設計技巧可以大幅減少記憶體到ALU的資料傳輸,但整個數位方案仍受馮紐曼架構的限制。這意謂著,有大量的機會可以減少功率浪費。如果執行MAC運算的能耗可以從約100pJ減少到若干分之幾pJ,將產生什麼樣的可能性?

圖3 機器學習運算中的記憶體瓶頸

消除記憶體瓶頸並降低功耗

如果記憶體本身可用來消除之前的記憶體瓶頸(圖3),則在邊緣執行推論相關的運算就成為可行方案。使用記憶體內運算的方式,可以大幅減少必須移動的資料量,也就能消除資料傳輸期間浪費的能源。快閃記憶體單元運行時產生的主動功率消耗較低,在待機模式下幾乎不消耗能量,因此可以進一步降低能耗。

以Microchip子公司Silicon Storage Technology(SST)的memBrain技術為例,該解決方案奠基於SST的SuperFlash記憶體技術,這項技術已成為適用於微控制器和智慧卡應用的多階記憶體的公認標準。此解決方案內建一個記憶體內運算架構,允許在儲存權重的位置完成運算。權重毋需資料移動,只有輸入資料需要從輸入感測器,例如相機和麥克風,移動到記憶體陣列中,因此消除了MAC運算中的記憶體瓶頸。

這種記憶體概念基於兩大基本原理:一是電晶體的類比電流回應基於其臨界值電壓(Vt)和輸入資料,二則是基爾霍夫電流定律,即在某個點交匯的多個導體網路中,電流的代數和為零。瞭解這種多階記憶體架構中的基本非揮發性記憶體(NVM)位元單元也十分重要。圖4是兩個ESF3(第3代嵌入式SuperFlash)位元單元,帶有共用的抹除閘(EG)和來源線(SL)。每個位元單元有五個終端:控制閘(CG)、工作線(WL)、抹除閘、來源線和位元線(BL)。透過向EG施加高電壓執行位元單元的抹除操作,同時向WL、CG、BL和SL施加高/低電壓偏置訊號來執行程式設計操作,並且向WL、CG、BL和SL施加低電壓偏置訊號以執行讀取操作。

圖4 SuperFlash ESF3單元

採用這種記憶體架構,用戶可以透過微調程式設計操作,以不同Vt電壓對記憶體位元單元進行程式設計。記憶體技術利用智慧演算法調整記憶體單元的浮柵(FG)電壓,以從輸入電壓獲得特定的電流回應。根據最終應用的要求,可以在線性區域或閾下區域對單元進行程式設計。

圖5說明了在記憶體單元中儲存多個電壓的功能。例如,如果要在一個記憶體單元中儲存一個2位元整數值,需要使用4個2位元整數值(00、01、10、11)中的一個,進行記憶體陣列中,每個單元的程式設計。此時需要使用四個具有足夠間隔的可能Vt值之一,對每個單元進行程式設計。圖5的四條IV曲線分別對應於四種可能的狀態,單元的電流回應取決於向CG施加的電壓。

圖5 ESF3單元中的程式設計Vt電壓

受訓模型的權重透過程式設計設定為記憶體單元的浮柵Vt,因此,受訓模型每一層,例如完全連接層的所有權重,都可以在類似矩陣的記憶體陣列上進行程式設計(圖6)。對於推論運算,數位輸入,如數位麥克風,首先利用數位類比轉換器(DAC)轉換為類比訊號,然後應用到記憶體陣列。隨後該陣列對指定輸入向量並存執行數千次MAC運算,產生的輸出隨即進入相應神經元的啟動階段,隨後利用類比數位數轉換器(ADC)將輸出轉換回數位訊號。然後,這些數位訊號在進入下一層之前進行池化處理。

圖6 用於推論的權重矩陣記憶體陣列

這類多階記憶體架構模組化程度非常高,而且十分靈活。許多記憶體晶片可以結合在一起,形成一個混合了權重矩陣和神經元的大型模型(圖7)。在此案例中,M×N晶片配置透過各晶片間的類比和數位介面相互連接。

圖7 memBrain的模組化結構

截至目前,文章主要討論了該架構的晶片實施方案。提供軟體發展套件(SDK)可幫助開發解決方案,除了晶片外,SDK還有助於推論引擎的開發。SDK流程與訓練框架無關。用戶可以在提供的所有框架,包含TensorFlow、PyTorch等框架中,根據需要使用浮點運算創建神經網路模型(圖8)。創建模型後,SDK可協助量化受訓神經網路模型,並將其映射到記憶體陣列。在該陣列中,可以利用來自感測器或電腦的輸入向量執行向量矩陣乘法。

圖8 memBrain SDK流程

多階記憶體方法結合記憶體內運算功能的優點包括:

1.較低功耗:專為低功耗應用設計的技術。功耗方面的第一個優點是,這種解決方案採用記憶體內運算,因此在運算期間,從SRAM/DRAM傳輸資料和權重不會浪費能量。功耗方面的第二個優點是,快閃記憶體單元在臨界值模式下以較低的電流運行,因此主動功率消耗非常低。第三個優點是待機模式下幾乎沒有能耗,原因是非易失性記憶體單元不需要任何電力即可保存始終開啟設備的資料。這種方法也非常適合在權重和輸入資料的稀疏性時加以利用,如果輸入資料或權重為零,則記憶體位元單元不會啟動。

2.減小封裝尺寸:該技術採用分離柵(1.5T)單元架構,而數位實施方案中的SRAM單元基於6T架構。此外,與6T SRAM單元相比,這種單元是小得多。另外,一個單元即可儲存完整的4位元整數值,而不是像SRAM單元那樣需要4×6=24個電晶體才能實現此目的,從根本減少晶片上占用的空間。

3.降低開發成本:由於記憶體效能瓶頸和馮紐曼架構的限制,很多專用設備,例如NVIDIA的Jetsen或Google的TPU,趨向於透過縮小幾何結構提高每瓦效能,但這種方法解決邊緣運算難題的成本卻很高。採用將類比記憶體內運算與多階記憶體結合的方法,可以在快閃記憶體單元中完成晶片運算,這樣便可使用更大的幾何尺寸,同時降低掩膜成本(Mask Cost)和縮短開發週期。

邊緣運算應用的前景十分廣闊,然而,首先需要解決功耗和成本方面的挑戰,邊緣運算才能得到發展機會。使用能夠在快閃記憶體單元中執行晶片上運算的記憶體方法,可以消除主要障礙。這種方法利用經生產驗證的公認標準類型多階記憶體技術解決方案,且此方案已針對機器學習應用進行優化。

(本文作者為Microchip嵌入式記憶體產品開發總監)

電流監測/記錄準又穩 藍牙電表設計便利/耐用兼具

而一般常見的數字萬用電表中,萬用代表多功能,電表的設計原理以基本電學V(電壓)=I(電流)×R(電阻)為理論依據。儀器與測量在現今社會科學普及的情況下越來越重要,研發人員的學習歷程以數字電表為入門,開始鑽研電子、電力、元件、溫度等測量概念,將測試的結果量化顯示,並且透過無線通訊傳輸紀錄與分析。此外,研究人員藉由實驗過程累積經驗,實現量測為設計之母的學習目的,有助於培育工程人才。

以OWON推出的掌上型藍牙數位電表為例,在數位化的需求下,為了增加學生、工程師或是研究人員在資料儲存的便利性,以及應對工作中常見的複雜測試情況,測試產品的某個參數時,需同時監測其他關聯指標。此產品在2015年4月由OWON基礎量測儀器商設計發表第一代藍牙電表B35,之後陸續推出B41/W16/OW18等藍牙與非藍牙兩種形式的數位電表(圖1)。

圖1 傳統三用電表(左)與藍牙多功能數位電表(右)

數位電表具靈活性且易於使用

新款數位電表有電壓、電流、電阻、溫度、二極體、電容、週期/頻率以及非接觸電壓量測等多種量測功能,同時有螢幕背光/LED以及藍牙資料傳輸通訊介面,可透過手機/平板App或者專用USB線與NB/PC連線(圖2)。大幅提升多機一體的量測功能性,顧及攜帶方便性以及紀錄資料實用性,滿足使用者多種環境的測試需要。而電表稱為基礎儀表,一直以來在使用上是最入門的電學量測工具。

對於新款的藍牙電表,需要讓使用者理解如何快速使用藍牙連線,因此團隊製作QRcode與說明書在包裝盒內,同時提供影片教學,使得使用者輕鬆上手。

圖2 數位電表透過LED以及藍牙資料傳輸通訊介面,可用於手機/平板APP或者專用USB適配器與NB/PC連線

多功能電表減輕電流監測負擔

就數位電表的實際使用經驗,以產品測試工程師Iwait.Lee的工作情境為例,可以應用在一些相對複雜的測試情況,測試產品的某個參數時需同時監測其他關聯指標。例如在一個電源產品上測試某個取樣電阻Rs上的電流以及溫度隨時間變化情況,Iwait.Lee需要一台電流表監測電流,同時使用一台溫度表或者紅外溫度測試儀測量溫度,而且還需開啟手機的碼表功能計時。開始測試時,碼表開始計算時間,10秒、20秒、30秒過去,還需要另外準備好紙和筆,記錄每個所需時間點的電流、溫度。若是一個人記錄、讀取兩個儀器的數值、並且查看時間,稍有疏忽測試資料就有偏差。

然而若是改用藍牙萬用表,Iwait.Lee僅需要2台B35和OWON免費的App。一台B35用來測量電流,另一台用來測量溫度,然後打開手機App,設置好取樣間隔時間10秒,再打開被測系統。透過數位化的量測技術,Iwait.Lee可以等到測試時間一到,關閉被測系統,直接查看手機測試資料,而且可以將這些資料選擇合適的格式保存起來或者分享出去,減少工作負擔。

電表設計趨向準確/耐用

數位電表基本的功能是穩定、準確且不易損壞,必須注意以下設計重點。

·準確度:解析度/位數Counts

1.萬用表的每個檔位元測量時對小訊號的分辨能力,量程越密就可以越靈敏地呈現被測訊號的變化(圖3),例如在220mV檔位設定,可以將量到最小的電壓解析為0.01mV。

圖3 解析度/位數COUNTS表 (資料來源:國家儀器NI)

2.Counts位數:比如選用B35/6位元的數位電表,最大顯示數位為5,999,解析度為量程的6,000分之一,同理Counts數越高解析度越高,可量測的訊號變化越細微。

3.準確度就是在特定條件下測量數值與真實數值的最大誤差。數位萬用表的準確度通常用讀數的百分比表示。準確度為讀數的1%,如果測量數值是100V,則實際顯示數值可能是99V和101V之間的任何數值。技術參數包括加到基本精度參數上的一位範圍(最後一位)。

耐用度20A保險絲與左邊的mA檔的自恢復保險(圖4),產品耐用度高於w同級產品的10A。

圖4 產品內部圖,中央HD500為保險絲,左側ㄇ字型零件為自恢復保險桿

藍牙電表的設計理念,即是減少使用者在資料紀錄與儲存上花費時間、精力與大筆的金錢來完成一件可以輕鬆完成的事情。用戶只需要:

1.下載App連線

2.啟用離線紀錄

3.下載圖檔或者csv的紀錄(圖5)

圖5 藍牙電表可快速記錄/儲存資料

即可簡單輕鬆完成資料紀錄,並繼續下一個實驗或者分析、報告(圖6)。

圖6 藍牙電表可快速記錄/儲存資料

藍牙電表兼具操作/讀取便利性

研發藍牙電表有一個很重要的關鍵,在於協助使用者遠離危險的環境,因此無論用戶的身體大小,姿勢或活動性如何,電表的設計上都為接近、觸及、操控和使用的情境提供了適當的大小和空間。

若將電表結合藍牙的即時傳輸和記錄,在很多工作中增進用戶體驗,包含高電壓、高溫、粉塵氣體等高污染有毒、有害的地方,以及操作空間狹小、觀察位置彆扭等不方便人工即時讀取、記錄的環境,藍牙遠端測量和記錄的功能就可展現出它的優勢。

(本文作者為OWON資深工程師)

電大尺寸問題分析不易 先進求解技術滿足5G模擬需求

宏觀/微觀都需考量 混合求解勢在必行

電尺寸的大小,是指電磁領域中的幾何尺寸與工作波長的比值。當物理尺寸遠大于電波長時,如10個波長、100個波長以上,一般就稱之為電大尺寸問題。電尺寸再增加到上千個波長,則可視之為超電大問題。

但在進行5G模擬時,不僅要考慮電尺寸的大小,同時也要考慮到幾何細節結構。因此,5G模擬不僅是個電大尺寸問題,同時也是個電大尺寸複雜問題,亦即待求解的問題不僅僅是一個電大尺寸或超電大尺寸的幾何規模問題,同時還存在複雜的幾何細節結構問題。這意味著模擬工程師要選擇一個適用於大規模問題求解的演算法,同時還要具備複雜問題的精確計算能力。這種情況下面臨的難點與挑戰主要有:

·單一的電磁演算法無法解決電大尺寸與複雜細節並存的問題

·傳統的網格剖分技術無法應對龐大且複雜的幾何細節

·大規模問題的求解,需要高效的平行運算技術與匹配的運算能力

為克服這些挑戰,採用可以結合各種演算法優勢的混合求解法,是必然的選擇。如利用有限元演算法(FEM)對於天線類複雜問題進行精確求解,積分方程法(IE)對於電大尺寸金屬體的電流映射求解,彈跳射線法(SBR)對於超電大尺寸問題的高頻近似求解等。通過幾種演算法的自由組合,可以恰到好處地解決電大尺寸複雜問題的演算法難點。

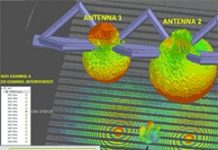

三維電磁場模擬軟體HFSS恰巧具備上述多種演算法的天然優勢,其內建的主要演算法模組包括有限元演算法、積分方程法、彈跳射線法、物理光學法(PO)及時域演算法。除了時域演算法以外,其他演算法借助於DDM域分解並行技術,均可同時應用於同一個問題或模型的求解,即混合演算法的協同模擬模式(圖1)。

圖1 HFSS混合演算法求解器

高效網格剖分技術縮短作業時間

電磁模擬軟體的不斷進步,離不開電腦技術的高速發展。若要將複雜的電磁模型,描繪出可以讓電腦識別並自動計算的語言,則離不開數值計算與離散化的網格模型。HFSS電磁模擬軟體支援強大的自我調整網格剖分技術,以自動化與精確化的特點,在模擬領域廣為人知。

HFSS軟體2019 R2版本中,推出了新型的Flex Mesh技術(圖2),可以極大的提高初始網格的劃分效率,降低演算法對模型幾何體品質的要求,從而大大縮短了大尺寸複雜模型的模擬時間,節省了工程師花費在修模型、簡化模型的大量工作,解決了傳統的單核網格劃分在應對大尺寸複雜模型時的低效率、高耗時問題,如複雜多層饋網的大型微帶陣列天線、大型複雜載體的多天線布局等。

圖2 新型Flex Mesh技術

多樣化的平行計算

HPC高性能計算,是所有ANSYS軟體並行技術的統稱。隨著大型叢集運算技術的不斷發展,ANSYS軟體的平行計算也在逐步改善與進步。

HFSS電磁模擬軟體目前支援的平行求解有多執行緒的共用記憶體式計算、分散式記憶體的矩陣計算、區域分解法的平行計算、GPU加速等。

另外,還有一種叫作DSO的任務分散式加速技術,可以實現頻率掃描的多頻點平行模式,以及參數掃描與優化中的多參數平行模型。DSO可以大大加速在頻掃與參掃等多工求解問題,充分利用硬體資源,進一步為設計探索提供更有利的高效加速計算。

圖3 HPC平行處理技術

合理的硬體資源配置

在進行大規模模擬問題的求解時,硬體資源配置(圖4)是實現軟體高效平行計算的最終執行體。根據模擬軟體的計算特點,配置合理的硬體計算資源,是實現大規模問題的高效率計算的前提,也是資源利用最大化、節省成本必不可少的關鍵。

圖4 硬體設定示意圖

HFSS軟體在網格剖分、自我調整反覆運算、頻率掃描、參數掃描等一系列的求解過程中,對硬體資源中的CPU、記憶體、硬碟、顯存、網路等的依賴度,理論上,當然是所有的硬體指標都越高越好,但是,如果預算有限,非要取捨的情況下,建議按照以下的優先順序考慮:首先是CPU頻率、其次是CPU數量,然後是記憶體、固態硬碟、機械硬碟、獨立繪圖記憶體、高速網路。值得注意的是,硬體配置需要均衡,因為問題的有效求解,是硬體資源整體平台的能力,不是某個單一元素的能力決定。

在同等求解規模,且資源足夠的情況下,單機求解通常要快於多機求解,工作站的求解速度也比叢集式超級電腦。具體原因主要是網路的資料傳輸問題,以及叢集式電腦的CPU因多核散熱問題,時脈通常都比較低,約在2.2到2.8GHz左右。作為對比,工作站所使用的CPU,目前時脈最高已超過4.0GHz。所以,要採用多機平行處理或使用叢集平台運算的話,一定要配置高速率的交換機或路由,以及高規格的網路等。

典型場景下的模擬詳解

高頻電磁場模擬在5G應用的開發過程中,主要集中在天線布局、訊號覆蓋與場景感知三大領域,以下將簡單介紹在進行這三大類模擬作業時,工程師所遇到的挑戰,以及如何解決問題的方法。

天線布局

將天線裝載到一定的應用環境或場景中,分析載體或環境因素對天線性能指標的影響,驗證天線設計指標是否真正滿足實際需要;並根據模擬或測試結果,調整天線的安裝位置,尋求最佳天線性能的布局方案,稱之為天線布局和優化設計,如機載天線布局、車載天線布局、星載天線布局等。

天線布局分析關注的仍是天線本身。遇到這類問題,我們首先要考慮的,不是天線的載體或環境有多複雜,多徑效應多難分析,模擬規模有多大等,而是我們設計的天線,究竟屬於哪種類型,電尺寸大小如何,敏感度如何,是否容易受到環境干擾。

在進一步討論這個問題之前,必須先對「電小天線」(圖5)的定義進行說明。所謂電小天線,主要指天線的最大幾何尺寸遠小於工作波長的天線。一般來說,天線的最大幾何尺寸若小於工作波長的1/10或1/(2π),就屬於電小天線範疇。電小天線的種類很多,如手機天線、耳機天線、手錶天線、Wi-Fi天線、GPS天線、北斗導航天線等。

圖5 智慧手表內建的天線,是電小天線的典型案例之一

許多工程師可能都遇過電小天線模擬結果不準確的情況,甚至有電小天線「模擬無用」這種極端的說法。會導致電小天線的模擬結果跟實際狀況出現顯著誤差,關鍵原因在於天線設計好之後,裝載到手機、電腦等終端設備上時,性能曲線會「大變臉」,導致原本的天線設計變得毫無用處,不得不用現場「手術」或「切銅皮」的方法來補救。許多熟悉這些工作的資深工程師,也因而成為同事口中的「銅皮大師」或「一刀切」高手。

而其根本原因還是在於電小天線的“小”和敏感變高等。相比於天線的載體或工作環境,天線的尺寸遠小於波長;而載體或環境中的某個金屬結構,反而更接近於工作波長,更易諧振於工作頻率。再考慮到電小天線的方向圖,都屬於類似於蘋果型的全向型,易受干擾,敏感度高。

所以,電小天線布局問題的解決方法,就是把載體與工作環境,當做天線的本身進行一體化設計,在設計天線的時候,就充分考慮天線的PCB結構、殼體、人體模型等環境因素的影響(圖6)。

圖6 遇上搭載小尺寸天線的應用時,工程師不宜只針對天線進行模擬,還必須把天線所處環境,甚至人體的影響一併納入模擬考量中

而天線陣列的布局分析,與電小天線正好相反。由於陣列天線的「地」夠大,陣列元素也多,方向圖波束一般都很窄,容易受到環境影響的因素不多或很少。這樣一來,載體或環境因素對天線本體的性能影響,是非常有限的。

天線布局分析,也僅僅是一種驗證的流程而已。例外的情況也有,主要是天線近場區加裝天線罩問題,如汽車雷達天線罩加上保險桿的模擬等。

信號覆蓋

天線設計完成後,評估其在具體的工作環境中,天線發出電磁波信號的有效覆蓋範圍。如5G領域的基站天線信號覆蓋、星載導航天線的地面覆蓋範圍等。

信號覆蓋問題的分析,關注的不再是天線本體,而是電磁波從天線發出後,到達目的地區域的信號衰減,哪些是在可允許範圍內,哪些超出了這個範圍。

這類超大尺寸問題的模擬分析,全波演算法不再適用,而要借助純光學求解器SBR+。目前SBR+求解器已整合在HFSS軟體,可用于求解天線布局、汽車無人駕駛場景模擬等。

對於一個暫態手機信號訪問量巨大的公共場所來說,如體育場,在常規的基站覆蓋條件下,GSM網路通信的暫態傳輸速率是遠遠不夠的。因此,對於新型的智慧體育場(圖7)來說,有效動態覆蓋的智慧小基地台組合,是一個不錯的解決方案。圖7的案例即是利用ANSYS電磁軟體HFSS中的SBR+技術,進行小基站動態覆蓋的模擬驗證,以滿足最小組合配置的前提下,動態覆蓋效果實現最佳。

圖7 利用HFSS中的SBR+技術,模擬小型基地台對體育廠內手機信號覆蓋的改善效果

另外,除了滿足手機信號傳輸規模以外,更高效的Wi-Fi網路信號覆蓋,是解決公共場所更大規模資料傳輸的必要手段。圖8是智慧體育場Wi-Fi網格布局優化與信號覆蓋的模擬驗證,主要考慮的是,在兩個Wi-Fi天線正常工作的情況下,設計出Wi-Fi信號對下方照射區的信號覆蓋最大化,而且不能產生盲區。

圖8 智慧體育場的Wi-Fi布局優化與覆蓋

場景感知

接收並檢測天線發射電磁信號的回波資料,通過一定演算法識別或感知場景中的目標特性資訊。如雷達散射截面積RCS與ISAR成像、無人駕駛中的微波場景成像等。

ANSYS HFSS軟體從2018.0版本開始,內建的SBR+求解器就開始應用於RCS模擬。主要針對多金屬結構體或帶塗覆層的金屬體,只要在HFSS建模環境下,設置目標體為SBR-Region,即可進行快速的RCS求解與腳本成像。由於SBR+求解器,依賴於光學射線的彈跳計算,不進行網格反覆運算,對於RCS問題的求解相當快捷。

而自2018.2版本以後,HFSS軟體新增加了SBR單獨的模擬環境,可以建立理想的天線源,也可以導入模擬好的天線方向圖結果,進行道路場景的動態參數掃描與頻率掃描分析。然後通過腳本功能進行IFFT變換為時域資料,得到ISAR、Range Profile、Water Fall、Range Doppler等成像結果。

模擬作業必須選擇最適方法

5G應用場景中的天線布局、信號覆蓋以及場景感知等電大尺寸問題的求解,也要看具體的問題來選擇合適的流程與方法。這裡主要從天線布局、信號覆蓋、場景感知等應用角度,給出了一些模擬的建議與軟體的解決思路探討,供各位業內同仁參考。

(本文作者任職於Ansys)

整合感測/通訊量測體重 計重檯秤系統成就智慧養殖

因此,在民以食為天的基本民生需求下,若沒有從「食」的來源端來管控或是有一套智慧生產的方式協助的話,飲食的問題就會變成不斷上演食物供需失衡的民生問題。而透過智慧農業的切入,將可逐步改善因天候或是人為所導致的各種問題。加上政府致力於智慧農業的導入與建立,以及大量大數據資料的分析與應用,可望逐漸降低不斷從產品生產過程或民生需求所產生的問題。換言之,在智慧農業中,用來量測飼養的家禽或水禽重量的應用於智慧農業之智慧型計重檯秤系統,就有其被開發的需求。

近年全球人口越來越多,糧食的需求也慢慢增加,同時受到氣候變遷所導致的極端氣候及鄉村人口老化、少子化的影響,導致農牧業人力減少許多。因此,政府開始推動智慧農業,結合無線通訊科技進行資料的蒐集,透過資料的整合及分析,減輕農場作業負擔及降低勞動力需求,建立更有效率的農場經營。其中,關鍵元素與作法包括制定相關農業科技策略,發展農業科技技術跨域整合之創新農業技術,重視農產品衛生安全與營養需求,並運用物聯網(IoT)、雲端運算(Cloud Computing)與大數據(Big Data)等技術,進而提升產品附加價值。

文中將說明整合紅外線觸控框(IR Multitouch)介面與具備RS-232串列介面的傳統計重檯秤裝置,該裝置運用邊緣運算的概念,精準地擷取與收集禽隻的數量與正確體重。最後,再將禽隻的體重與數量結果透過NB-IoT無線通訊模組傳送至網頁上,並紀錄每天禽類體重長成的過程,以了解如何孕育出最佳飼料轉換成禽隻體重的最佳養殖環境。

解決台灣養殖體重測量痛點

製做本系統的目的,是針對國內本土環境所提出的應用。透過智慧禽舍採用的智慧型計重檯秤系統,可以針對不同生長周齡的禽隻進行適合其生長的重量擷取與分析,並將環境綜合資訊及參數收集於資料庫,進行分析與經驗數據累積,提高飼養管理效率與品質,並有效節省人力,邁向智慧化生產與管理。

台灣正在邁向智慧養殖,會使用智慧禽舍來監控家禽或水禽的生長環境與飼養過程。其中,最難收集到的數據就是家禽或水禽的成長體重,因為無法固定禽類的動作與位置,使得禽類的重量數值僅能估算或是常出現誤差值。因此本裝置利用紅外線多點觸控取代影像辨識,來計算禽類的數量,可更準確且方便的偵測禽類的數量。一般影像辨識都需要經過較繁瑣的演算法與軟體分析,技術性較高且花費時間多,還會因為光線等外在因素導致判斷錯誤。而改用紅外線觸控框介面,則可以更快速且方便的取得數量,同時搭配計重檯秤取得重量數據後,即可上傳至網路,農場主人便能隨時隨地查看禽類的生長曲線。

此外,此裝置亦內建各種禽類的成長曲線表,確認所擷取的體重是否超出標準值的上下限,進而確保系統收集到準確的禽類體重。由於不同禽隻類型的成長重量曲線不一樣,因此可以運用指撥開關來設定所飼養的是否為家禽(雞)或水禽(鴨),進而達到智慧化傳統計重檯秤的目標。

紅外線感測取得精準數據

在應用於智慧農業之智慧型計重檯秤系統設計中,使用Holtek HT66F2390微處理器為核心。其中,主要利用紅外線觸控框取得感測資料,再使用NB-IoT模組將資料存入資料庫,供網頁監看與使用。

UART串列介面

UART是一種通用非同步收發傳輸器,通常稱作UART,其為將資料由串列通訊與並列通訊間傳輸轉換。UART通常用在與其他通訊協定(如EIA RS-232)的連結上。在串列傳輸通訊協定的格式內容中,是由四種資料共11個位元所組成,共分為起始位元(Start Bit)、資料內容(Data)、奇偶同位元檢查碼(Priority Bit)、停止位元(Stop Bit)。

如圖1所示,資料透過FIFO(First Input First Output)的方式,由最低有效位元(Least Significant Bit, LSB)開始傳輸直至最高有效位元(Most Significant Bit, MSB),奇偶同位元(PB)可以選擇忽略不使用。在此系統利用計重檯秤 (DHBH-W)的UART串列介面,讀取磅秤上的重量,並以UART將資料傳輸至微處理器解析。最後,再透過NB-IoT無線通訊模組(SIM7020E),以UART做初始化,並將處理後的資料透過NB-IoT無線通訊模組上傳至MQTT伺服器。

圖1 UART資料傳輸格式示意圖

USB通訊協定/人性化介面

由於紅外線觸控框為USB HID人性化介面裝置。因此,須了解USB協定的基本原理。在USB完整的通訊協定中,包含了USB封包、傳輸類型、描述元、裝置要求、群組等USB規格書中相關的協定。唯有遵循此協定,才能執行USB周邊裝置與PC之間的資料傳輸與命令的設定。如下圖2所示,顯示了USB主機端如何與裝置執行通訊協定的傳輸格式。從圖2中,也可看出一個通訊協定所需包含的各種封包與各類型欄位。

圖2 標準USB控制型傳輸

在USB的傳輸中,因不同周邊裝置的類型與應用,訂定了四種的傳輸類型,分別是控制型傳輸(Control Transfer)、中斷型傳輸(Interrupt Transfer)、巨量傳輸(Bulk Transfer)以及等時型傳輸(Isochronous Transfer)。其中,需要特別注意的是慢速裝置僅支援控制型傳輸與中斷型傳輸而已。在USB裝置中,則針對不同裝置的應用特性,個別地執行中斷傳輸、巨量傳輸或等時傳輸。

而USB...

強化天線效能/抗干擾演算法 雙模滑鼠多工切換減干擾

無線電腦輸入裝置如鍵盤、滑鼠等等在日常生活中可以說是必備的裝置。這些無線裝置通常依賴藍牙或是無線Dongle模式來達到無線操作,被使用的無線協定雖然都能達到無線傳輸的目的,但在不同使用領域內,使用者的需要卻大大不同。

如在商辦環境下,若使用者需要在多台電腦上以同一支滑鼠進行控制與操作,在藍牙模式下進行這項操作就會變得困難,因為各台電腦都在發射藍牙訊號,嘗試與滑鼠連接,因讀者一定都先配對過了,但滑鼠又沒有螢幕可以選擇要連接哪台電腦,最終就會造成要關閉其中一台電腦的藍牙功能來達成多台電腦控制,讓讀者真的花很多程序來達成多工。為了滿足這個需求,有廠商就推出雙模的無線滑鼠。透過藍牙與Dongle模式在滑鼠上能夠自由切換,便解決了上述問題(圖1)。

圖1 Dongle與藍牙模式切換達到多工目的

另一種使用領域是現在很熱門的電競產業。這類型的使用者要求的是極高的滑鼠靈敏度及反應速度,這時候若是使用藍牙模式,大部分都無法滿足這種高強度的傳輸要求。其原因是藍牙透過USB HID規範下回報的速率不夠高,需要跳脫此規範來達成。此時需要搭配廠商自行設計的驅動程式,才能夠正常使用滑鼠,所以讀者會發現無線電競滑鼠幾乎都使用獨立的Dongle來實現此規格(圖2)。

圖2 市售電競滑鼠常使用Dongle達到高強度傳輸規格

以下來討論無線滑鼠的共存表現。如第一段所提到的使用場景,無論是在辦公室環境或是在電競比賽現場,在整個環境中一定充斥著各類無線干擾。根據百佳泰實驗室的無線測試經驗,本文將2.4GHz無線共存的問題,對於無線滑鼠可能造成的影響,歸納了下列狀況:

·滑鼠游標移動過程中產生停頓

·滑鼠操作直接失效

對應到這些問題,即使滑鼠本身有使用藍牙跳頻機制或是Dongle模式下由廠商自身開發的跳頻演算法,但其真的有辦法抵抗干擾嗎?能夠保證讀者的簡報過程順利,或是在電競戰場上贏得比賽?這些連線問題會造成不良的用戶體驗,使用者在網路銷售平台上給予負評回覆,如此除了影響到產品的銷售表現,也讓其他消費者對於品牌產生負面的印象。

以上這些無線共存問題,將透過本篇文章的3個段落「環境架設」、「工作表現判斷基準」、「實際測試結果」,來比較市售兩款商用的雙模無線滑鼠在無線訊號干擾情況下的問題和劣化(圖3)。

圖3 市售兩款雙模無線滑鼠

無線滑鼠測試環境架設

所有的雙模無線滑鼠測試項目都會在電波隔離室中進行,如此隔絕外界電波干擾的因素,進而得到穩定的測試結果。另外在測試過程中為了要分析在干擾情境下雙模無線滑鼠的表現,搭配滑鼠游標移動治具,來執行定性定量的移動並記錄回報頻率(Report Rate, RR)數值與游標軌跡,如此精確且即時的量測結果,有利於後續結果的分析及討論,整體架設如圖4所示。

圖4 雙模無線滑鼠無線共存測試架設圖

在模擬不同場域的干擾測試情境,各種場域中會有幾種不同的干擾情境考量,如不同無線通訊技術(Wi-Fi及藍牙)、不同通訊裝置的數量,訊號密集度不同(高速或低速技術)都將透過實驗室模擬出來進行測試對比。

現在以實際架設各種場域中常見無線產品為例,如透過藍牙喇叭、Wi-Fi無線路由器、智慧型手機等產品互相通訊來製造流量,控制其頻譜使用狀況及頻道使用率來模擬不同場景。

雙模無線滑鼠工作表現判斷基準

本文提供的無線共存測試判斷基準是以滑鼠回報的Reporting Rate及滑鼠游標移動的順暢度作為判斷依據,檢測的項目為下列兩項:

·Reporting Rate監測

一般無線滑鼠的Reporting Rate大多在125Hz,但在共存干擾影響時,若其數值降低至100Hz以下,使用者會感覺到滑鼠控制或反應能力變差。

·游標移動軌跡監測

除了RR的表現,本文也將以影片紀錄的形式來監控游標移動的平滑度,觀察使用者實際使用時可能感受到的困擾。

RR/游標移動監測實際測試結果

本文以D、L兩間廠商的雙模無線滑鼠進行驗證,並藉由圖5來看當干擾情境惡化帶來的影響。圖中的X軸為干擾條件、Y軸為Reporting Rate的變化,基本上RR數值越高越好。

圖5-1 Reporting Rate測試結果

圖5-2 Reporting Rate測試結果

·Reporting Rate監測

無論是在藍牙或Dongle模式測試結果中,可以觀察發現當增加干擾數量時,L廠商的滑鼠在一個Wi-Fi干擾情境下已經發生RR下降的情形;相對而言,D廠商的滑鼠還能維持在125Hz左右;當干擾數量再增加至3個Wi-Fi干擾情況時,L廠商的滑鼠RR急遽下降到只有40Hz,但D廠商的滑鼠依舊持續保持在100Hz以上。最後增加到5個Wi-Fi干擾與3個藍牙干擾同時發生,兩個滑鼠RR差距越來越大。

·游標移動表現監測

那L廠商的滑鼠的實際用戶體驗於上述幾個干擾情境下會是怎樣的表現呢?以下透過圖6、7與8來說明。圖6為無干擾情況,可以看到游標移動非常順暢,過程中沒有任何停頓(注意游標殘影)。但在3個Wi-Fi干擾狀況(圖7)已經發現有點不順暢的現象;最後在5個Wi-Fi干擾與3個藍牙干擾(圖8)同時發生的情況下,可以明顯看到游標移動發生不連續或是頓點的現象。這時的使用者體驗一定是不好的,可能這時候用戶已經有要退貨的心理準備。圖9是D廠商在與圖8相同條件下的游標表現,可以發現有稍微不平滑,但還是可以保持在使用者可以接受的範圍內。

圖6 L廠商在無干擾下的滑鼠表現

圖7 L廠商在3個Wi-Fi干擾下的滑鼠表現

圖8 L廠商在5個Wi-Fi與3個藍牙干擾下的游標表現

圖9 D廠商在5個Wi-Fi與3個藍牙干擾下的游標表現

各方多管齊下解訊號干擾難題

總結以上Reporting Rate與游標表現測試結果,得知D廠商的的雙模無線滑鼠在無線干擾的情況下,仍能保有較佳的工作表現。至於兩間廠商的無線滑鼠為何會有如此大的差異?本文推測可能有以下幾點可能:

·滑鼠本身天線效能差異

·無線發射模組輸出功率高低不同(但也需考慮電池壽命)

·Dongle模式下抗干擾演算法有無優化

如何驗證產品在現今2.4GHz訊號擁擠頻段中的操作性,已經是周邊廠商開發的重心,越來越多廠商都在腦力激盪透過硬體、韌體或驅動軟體來確保無線滑鼠能夠正常工作。

在無線產品越來越多的情況下,無線共存的問題只會越來越被市場重視,測試實驗室了解這個需求,如百佳泰為客戶品質把關,從關注使用者體驗,到多樣化的干擾情境場域設計,協助讀者在後續強化自己的產品,讓使用者在實際環境中得到更佳的使用體驗,並提升產品的市場競爭力。與此同時,本文藉由雙模無線滑鼠作為測試案例,測試其在無線共存環境下的使用效能。

(本文作者為百佳泰無線驗證實驗室主任工程師)

提高成本效益 8-bit MCU簡化CAN汽車應用

CAN滿足汽車資料傳輸需求

傳統的CAN通訊以事件為基礎,允許微控制器和專用積體電路(ASICs)在應用中直接相互通訊,採無主機設計。CAN經過半導體公司整合後,大規模地降低了成本,並且能夠與更多汽車系統相容。自2000年初以來,8位元MCU也導入了CAN協議。2015年最先推出的8位元MCU設計方案加入核心獨立周邊(CIP),新問世的8位元MCU系列能夠解決CAN應用上許多系統的問題。

除了成本效益高之外,CAN的成功還可以歸功於其穩健性、可靠的資料傳輸,以及易於實現的特性。毫無疑問,除了成本效益極高之外,8位元MCU還具有上述優勢。因此,8位元MCU和CAN的優良組合,滿足汽車網路需求,也降低節點的成本。根據過去的經驗,CAN能夠滿足各種控制系統的需求。隨著汽車網路需要的各種屬性不斷增加,包括時間觸發、容錯和單線實現以及具有靈活資料傳輸速率的CAN(CAN FD),CAN規範也得到擴展。表1所示為30多年前首次推出CAN以來所發生的諸多變化。

為了將感測器和致動器聯網以提高系統舒適度,汽車工程師使用區域互聯網路(LIN)協定來降低成本。但是,LIN是單線主從式網路,需要更改使用CAN的硬體和軟體。使用CAN的最新汽車應用包括門禁控制、電池充電/電池管理和診斷設備。為了滿足車輛全部的要求,尤其是從另一個CAN控制系統存取車輛資料的要求,通常就需要使用8位元MCU/CAN。圖1是將8位元MCU/CAN節點添加到現有CAN匯流排的範例。

圖1 不同的CAN可以共存,增加了CAN匯流排的靈活性

8位元MCU實現低成本網路需求

連接到CAN匯流排是系統設計人員需要實現的最低功能,透過增加專門用於滿足其他系統要求的周邊,簡化設計人員的任務。這些系統任務包括感測一個或兩個用於控制目的的參數、馬達轉動的位移、啟動電磁線圈或者提供其他功能。

使用CIP方法可以降低軟體的複雜程度,並以較低的時脈速度提供更快的回應時間,同時降低功耗。在Microchip PIC18 K83系列中的CIP系統類別包括:

·智慧類比(包括感測器介面)

·波形控制

·時序和測量

·邏輯和數學

·安全和監視

·通訊

·低功耗和系統靈活性

在這些類別中,具體周邊包括:

·帶有記憶體掃描的迴圈冗餘校驗(CRC),用於確保非揮發性記憶體的完整性。

·直接記憶體存取(DMA),用於在沒有CPU參與的情況下進行記憶體和周邊之間的資料傳輸。

·視窗看門狗計時器(WWDT),用於觸發系統重設。

·帶計算功能的12位元類比至數位轉換器(ADC2),可自動進行類比訊號分析,進而實現即時系統回應。

·互補波形發生器(CWG),用於達成馬達控制的高效同步開關。

除了使用CAN 2.0B外,整合CAN控制器還能夠完全相容以前版本的CAN模組(CAN 1.2和CAN 2.0A)。該產品的功能包括記憶體存取分區(MAP),用於在資料保護和自我載入程式應用中為設計人員提供支援。元件資訊區(DIA),則用於為工廠程式設計的元件ID和周邊校準值提供專用儲存空間。

由於CAN節點的主要目標是通訊,因此8位元MCU改進了串列通訊,包括支援非同步通訊和LIN協定的UART以及更高速的獨立I2C和SPI串列通訊介面。圖2顯示了15種CIP以及它們滿足具體系統需求的方式。過去並沒有考慮過在8位元MCU中實施這些on-chip結構,而正是由於這些結構,現在的8位元MCU的性能與許多設計人員的期望完全不同,所提供的功能遠遠超過十年前設計的MCU效能。

圖2 PIC18 K83系列中獨立於核心的周邊,可滿足多種系統需求

8位元MCU的程式設計方式非常簡單,與CAN和CIP結合使用時甚至更加容易。當這些8位元MCU能夠提供足夠的處理能力時,特別是針對遠端節點的處理能力,便能夠替代更昂貴且更難程式設計的16位元MCU。而CIP可以提供更多處理能力,實現更多8位元MCU選項。可靈活配置的on-chip硬體模組,能夠更高效更確定地處理重複嵌入。事實上,由於CAN具備良好的穩定性,如果MCU卡在迴圈的運作時,使用CIP的CAN仍然可以在核心之外繼續運行。

借助最新的8位元MCU/CAN+CIP和LIN,網路設計人員現在可以為CAN和LIN通訊提供更多靈活性和選擇。實際上,一些典型的8位元MCU LIN應用現在是潛在的CAN應用。例如,如果模組需要瞭解網路上的其他資料(如車輛速度),CAN可能是更好的選擇,或者至少是LIN的備選方案。模組所蒐集到的數據對於擋風玻璃雨刷非常有用,可以協助系統根據車輛的速度改變雨刷速度,而無需CAN到LIN的閘道。另外,如圖2所示,使用系統級CIP可以少用一、兩個額外的ASIC。

多年來,汽車中一直使用相同的PWM和互補波形發生器CIP產生相當複雜的多色LED氣氛照明。由於MCU沒有應用CAN功能,這些驅動程式會連接到LIN匯流排。而目前將該功能與支援CAN功能的高性價比8位元MCU相結合,可為設計提供更高的靈活性和簡化的備用方法。

雖然市面上大多數8位元MCU都嚴重的依賴核心來處理周邊功能,但CIP可實現其他系統設計的可能性,不會對CPU造成明顯負擔,包括各種感測器的高精度介面、高功率LED驅動器和/或相當複雜的馬達控制水準。

使用者可以測試各種開發工具,確定哪些工具和其他可能性中的哪一種適合特定網路。例如,MPLAB周邊函數產生器(MCC)是一款免費的軟體外掛程式,可提供圖形介面來配置特定於應用的周邊和功能。借助該工具,系統設計工程師在完成特定任務時可以配置基於硬體的周邊,而不必編寫和驗證整個軟體程式。

CAN具高度成本效益

對於汽車和工業應用中的匯流排架構,系統設計人員有多種選擇。作為一種廣受多數採用的匯流排,當需要為現有網路增加檢測和/或控制功能時,具有附加功能來滿足不同系統需求的MCU使CAN成為一種良好的選擇。憑藉其獨立於核心的周邊,8位元MCU/CAN系列可將CAN擴展到網路上更具成本效益的節點中。新型8位元MCU/CAN+CIP為新興汽車網路應用提供了靈活、經濟高效、簡單而可靠的資料傳輸以及存取控制、電池充電/電池管理和診斷設備所需的更高性能和系統支援。

(本文作者為Microchip 8-bit MCU部門產品行銷經理)

旋轉運算扮演關鍵角色 感測融合促環境感知超展開

加速度計、陀螺儀和磁力計通常以消費者價格點提供有效的動作資訊。消費者級的慣性測量單元(IMU)是大多數電子裝置觸發動作的關鍵,然而最能說明問題的,並非是其產生的原始數據,而是透過分析和理解感測器的各項數值,帶來更多的啟發,這就是為什麼會有感測融合(Sensor Fusion)的概念出現。

感測融合的重點在於如何合併多個感測器數據,以及對不同感測器數據的取捨,只要將增益、偏置或雜訊等感測器異常納入考慮,便能較容易了解到那些需要偵測手勢及電源管理的產品為什麼會如此複雜。

想要了解如何在IMU中整合感測器數據,就需要了解旋轉以及控制的方法,本文將說明不同類型旋轉的表示法及所需的操縱方式,還會介紹Arm Helium技術(M-Profile Vector Extension, MVE)是如何幫助客戶在Arm Cortex-M處理器上產生更快的結果,僅以一個四元數(Quaternion)就能提升指令速度約2.5倍,使用八或更多個四元數速度將提升4倍。

多種旋轉表示法

從基礎開始絕非壞事,所以本文將從定義旋轉開始。旋轉是維持方向不變的正交變換,即點與點間的距離和向量間的角度不變,且無任何形式的延伸或傾斜。

旋轉可用兩種方式來思考:旋轉向量或旋轉座標系,這兩種的方式相同但主體相反。前者是以面對自己的方向轉動骰子(物體旋轉),後者是將骰子置於桌上並自己繞桌旋轉(座標系旋轉)。

旋轉可用多種數學函數表示,各種方式都有其優缺點,對座標系、符號、框-向量旋轉及非可交換旋轉,各有潛在的困難點,每種方法利弊如下列所示。

歐拉角

歐拉角的基礎原理是用三個角度來表示空間中發生的旋轉,共可以生成十二個獨特的旋轉順序,其順序可為外旋(旋轉軸全域固定)或內旋(旋轉軸隨裝置移動),其中外旋很少用於運算。

在俯仰(Pitch)、偏航(Yaw)、橫滾(Roll)順序中最常見的也許是航空歐拉順序,如圖1所示,圖中採用NED座標系(北-東-下),分別代表X、Y、Z軸。

圖1 航空歐拉順序

參閱上圖能深入地了解內旋順序。以Z-Y'-X"順序而言,先繞飛機/重心(Z)的中心旋轉,然後從新位置繞機翼(Y')旋轉,最後繞機身圓柱中線(X")旋轉。這一俯仰、偏航、橫滾序列的角稱為Tait-Bryan角,但一般稱為歐拉角。

歐拉角易於閱讀和理解,因此有助於概念化和使用者輸入,但不利於運算或插值,比如將偏航和俯仰視為地球的緯度和經度,則在赤道的一度運動會比在極地冰蓋處的一度運動大很多。

主要缺點之一是發生在接近π/2或90度之第二次旋轉的環架鎖定(Gimbal Lock),此現象能用圖1解釋。繞重心旋轉任意角度,然後俯仰飛機至90度,此時飛機就會垂直向上,在這一點上,飛機繞中線和重心旋轉效果相同,此會導致系統進入二維自由度(DoF)狀態,而失去第三維自由度,因而產生多餘的等效旋轉,並使運算複雜化。

方向餘弦矩陣

旋轉矩陣亦稱DCM,是一個3×3矩陣:w=Rv,其中R是旋轉,v是向量。DCM將一個參考座標系轉換為另一個參考座標系,等於用矩陣表示各個歐拉角旋轉的乘積。

使用時必須有一個正交矩陣,其中R-1=RT and Det(R)=1,來代表純旋轉(無延伸或傾斜)。

此方法可避免環架鎖定,但這種方法的缺點,是確保矩陣在操作後保持正交性,將可能不易運算。

軸-角

與需要三個旋轉的歐拉角相反,軸-角表示法只需要一個旋轉。此一方式下,任何旋轉都可以用圍繞任意軸n的單一旋轉角θ表示(圖2)。

圖2 軸-角

本方法的優點在於運算過程只須操作兩個數值,而不是如歐拉角的三個數值和DCM的九個數值,這改善了歐拉角所缺乏的數值穩定性,也毋需如DCM進行重新規範化,及歐拉角的環架鎖定,但是它的缺點是不太適用於額外的運算。

四元數

四元數可與其他旋轉方法結合或作為替代方法使用,是定義旋轉的首選。此表示法使用的複數具有一個實項和三個虛項:q=w+xi+yj+z,其中w是實項,x/y/z是虛項;若用向量表示,q==,其中w是實項,a是向量。

四元數沒有環架鎖定的風險,在數值上也比DCM更穩定,沒有冗餘因素、不需要昂貴的操作正交化、易於保持正規化,而正規化的四元數類似軸角法,可以表示旋轉角度的任意向量,因此更容易解釋—w是角度w=cos(θ/2)的變形版本,a=是軸的比例版本:

在四元數中,四元數數學的加法是向量加法,即所有元素的和;乘法略微複雜而且不可交換。如定義P為(p0,p)且Q為(q0,q):

在規範化(單位)的四元數中,逆矩陣等價於共軛(Conjugate):P-1=P*,而旋轉向量(v)四元數q的量:w=q*vq;v=qwq*;w=Rv(R是DCM3×3矩陣)且存在於四元數。

合併旋轉是四元數乘法:

且可由四元數Q旋轉向量v後再返回:

四元數因支援插值和導數,因此有利於感測融合,軸-角法和歐拉角法均難以插值,雖然可以使用DCM進行插值,但因要對九個元素(3×3)進行操作而難以執行,且相較於DCM,四元數只需要四個元素(w/x/y/z),因此也可提高儲存效率。

如上所述,四種數學方法各有其優點和影響運算便利性的潛在缺點。其中四元數在感測器整合的旋轉運算上更受青睞,因為四元數可以避免環架鎖定、確保數值穩定性、對訊號進行插值且提高處理效率。

但是如果要執行大量旋轉,對於四元數運算是很大的挑戰,由於四元數乘法需要大量獨立運算,以致於實際運算效率可能比DCM低,尤其連續進行大量旋轉時,四元數乘法的操作程序將比矩陣乘法複雜。

四元數乘法

Arm Helium的指令集可以快速進行四元數乘法,而在說明其加速方法前,需要對四元數和四元數數學進一步說明,如前文所述,四元數的旋轉需要進行多個乘法運算,亦即四元數乘法是旋轉的關鍵,例如定義四元數A、B及R如下:

其中a=,b=,r=,擴展為16個乘積累加/累減:

或可將四元數視為一對複數,例如a和b是實數,則複數a+bi可表示為一對(a,b),四元數A=,因此可表示為(a1+a2i)+(a3+a4i)j,其中ij=k,亦即將四元數A表示為負數對(a1+a2i,a3+a4i)。

將複數相乘的結果如下:

亦即兩個四元數可用兩對複數表示如下:

全部乘法運算合在一起等於16個實數或4個複數的乘積累加/減運算。

採用新指令集

Arm Helium技術包括一個向量複數乘法累加VCMLA指令,此指令可以執行一半的複數乘法,而使用兩個不同「旋轉」值的調用,可以運算出一個完整的複數乘法。

調用VCMLA兩次:

1.r=vcmla(r,,,0)

2.r=vcmla(r,,,90),產生r=,亦即每次調用僅需要兩個純量乘法累加。而VCMLA指令能夠一次運算多個f32和f16複數(定點運算有專用運算子)。而由於四元數可以用兩個複數表示,因此特別有用。

總而言之,四元數乘法的複雜運算如下所示。

此乘法可調用VCMLA指令四次來完成:

前述的16個實數乘法累加/減運算可改為對VCMLA指令的四個不同調用,每個調用執行四次乘法累加。在前兩次運算後,產生八個等效置換結果,如圖3所示。其中最好使用粗體的四個置換,因為它們對於第三次和第四次VCMLA調用有相同的輸入,這一點很重要,因為就指令獲得的速度而言,不可輕忽更改輸入所耗的時間。

圖3 旋轉置換

Helium應用範例

進行四元數乘法前,需先調用其他指令來置換和求逆輸入數據,再調用VCMLA指令。這些存取模式可用常量陣列或手動生成,以下實例會演示此版本的執行:

本四元數乘法的優化代碼如圖4所示,在VCMLA運算代碼中,灰底標示的部分代表四元數乘法。本實例使用多種方法:如{0,1,0,1}用增量/迴繞(viwdup)生成;{2,3,2,3}是人工構建的演算法;{3,2,1,0}用增量(vddup)生成;符號修改碼從表中載入,但也可用vdup/vmov生成。

圖4 四元數乘法代碼

加速指令處理

CEVA-Hillcrest Labs利用Arm作為其DSP核心。本文將Arm Cortex-M0和Cortex-M0+處理器具有的1-cycle或32-cycle的乘法選項,用於感測融合。雖然Cortex-M3也有相同的功能,但對於較小的代碼大小和MIPS而言,其具有更高效的代碼,因此更能節能。配備FPU的Cortex-M4,則提供了更小的代碼和更少的MIPS。

然而,借助Arm Helium的技術,可以同時執行多個四元數乘法,來快速地產生結果,如表1所示,其中NoQ為同時進行的四元數乘法運算;He為Helium擴展所採取的循環數;Cortex-M4為Cortex-M4執行採用的循環數;Cortex-M7為Cortex-M7執行採用的循環數;CPQ為給定運算的每個四元數運算循環數。

而表2則列出使用Arm Helium替代其他Cortex-M應用方案,所得到的速度提升,其中Ratio為給定運算與MVE運算相比處理時間的百分比;Speedup為MVE相對於給定運算的速度提升之比(比率的倒數)。

由此可知,Helium的效果顯著,僅用一個四元數就能提升指令速度約2.5倍,若使用八或更多個四元數,速度將至少提升4倍。

感測融合至關重要

隨著人們的生活越來越緊密,感測器在日常生活中變得越來越普遍。為了滿足這種便利性,感測器須以低功耗、快速、準確地認知周遭環境,因此,複雜四元數旋轉的感測器整合,便是建立此一認知的關鍵。

(本文作者Fabien Klein任職於Arm;Bryan Cook及Charles Pao皆任職於CEVA)

車載電氣系統超前部署 48V輕油電擁抱新應用

48V技術為了遵循CO2規格,可實現再生煞車及中間能源儲存等功能,之後還能針對傳統燃燒引擎提供電氣支援,不過在未來限值方面,似乎無法重現相同效益,因此許多汽車製造商都以HV-BEV為發展方向。圖1顯示在遵循未來限值的情況下,電動車市占率可能的發展情形。這說明為何各界通常將48V車輛電氣系統視為銜接技術。

圖1 ICE、48V輕油電混合車及電動車在遵循未來限值的情況下,可能的市占率發展示意圖

就技術觀點而言,本地零排放的純電動車顯然是理想解決方案,必須依此進行開發及推廣。不過是否要完全仰賴HV電動車,則成為各界爭論的話題。其中的風險在於燃料電池或CO2中和合成燃料等充滿潛力的技術,其開發工作可能會因此受到影響,導致喪失潛力十足的關鍵技術。此外如果全球改為使用純電動車,在原料生產及能源產生方面,還無法達到CO2中和的境界,特別是能源組合及HV電池的生產及回收問題,可能對碳足跡造成負面影響。其中的決定性因素,將是實作電動車技術在未來實現CO2中和目標的時間,以及48V車輛電氣系統如何為此提供支援。因此以下主要將探討48V車輛電氣系統是否只能作為銜接技術,以及是否具有進一步的發展潛力。

48V架構/應用逐步成市場矚目焦點

動力傳動系統有各種電機(EM)整合選項(P0至P5)。連接式燃燒引擎的「增壓」及「動能回收」,以及分離式燃燒引擎的「滑行」等基本功能,可在所有組態中實現,其中分離運作時必須使用自動啟動離合器。有別於受曲柄軸速度影響的P0及P1組態,P2至P5組態的共同點,就是可在內燃機引擎分離時回收煞車動能,並在48V系統的效能範圍內實現純電動駕駛。P4及P5架構也能以48V系統為基礎實現全輪駕駛功能。

不論驅動時使用的是HV-BEV、燃料電池或合成燃料,其他裝置的48V電壓位準都比12V更節能,在車輛中的安裝及運作也比HV更簡單,具有最佳化的可能性。視驅動概念而定,圖2顯示可能的48V應用,例如2~4kW的電動渦輪增壓器(eTurbo)、4~5kW的電動空調壓縮機(eA/C)、1~5kW的電動催化劑加熱(eCAT)、PTC輔助加熱器及擋風玻璃除冰等電動加熱器、1~5kW的電動驅動及滾動穩定(ERC)、最高1kW的泵及風扇,以及其他需要高電源密度及/或連續使用的應用。目前採用P2-P4組態的第二代輕油電混合車,正以48V為發展方向開發前述應用,此外也在HV-BEV作為第三電壓位準。

圖2 搭載48V輔助裝置的雙電壓車輛電氣系統示意圖

如果再稍微進一步探討都會行動商業部門的未來發展,或是所謂的「公共運輸行動服務(MaaS)」整體概念,就能為48V技術開創更多應用機會。相較於HV-BEV目前所需因應的極長範圍(>400km)及持續縮短充電時間等需求,48V技術的主要焦點為成本、電池重量、隔離保護,以及2km至20km的短距離行駛。有足夠時間在工作期間、整夜或類似期間進行充電,視車輛基礎設施及停車情形而定。對此項需求而言,計算顯示30kW驅動足以讓小型都會車完成都會及陸上的標準週期。此外,48V BEV動力傳動系統的成本,在此運作週期中約比HV400V BEV動力傳動系統便宜25%。目前市面上已經有負載最高1,000kg的商用車採用48V BEV,而採用48V BEV的摩托車及電動機車也在市場上站穩腳步,部分車款甚至採用可更換電池。以上所有實作都能採用已開發或預定開發的輕油電混合車應用,例如含電池管理系統(BMS)的電池、變頻器、DC/DC轉換器及輔助設備。

MaaS如何持續發展仍是問題所在。即使是傳統汽車製造商,目前也重新調整定位,並擬定策略轉型為MaaS供應商,定義全新的生態系統。這類車款因應完整行動力範圍的問題,除了可讓數人搭乘的小型都會車外,也有類似於EasyMile的「接駁POD」,提供12位乘客的運輸能力,並以類似於巴士的「人員移動裝置」及「貨物移動裝置」作為最後一哩服務。前述車款由於重量高於小型都會車,因此需要更高的電源密度。這可能讓48V不僅用於傳統動力傳動系統及輔助裝置,也將用於轉向、煞車及駕駛穩定性等項目,此外也可能用於輪轂馬達。類似應用也出現在卡車、農業、營造機械、堆高機、特殊車輛及航空市場。

即使前述應用只有部分獲得實作,且未來發展仍有很長一段路要走,但這有可能大幅延長48V的生命週期。

48V架構巧搭車載元件精準控制

48V車輛電氣系統的半導體,主要用於控制電動馬達、配電變頻器或向輔助裝置供電,還以DC/DC轉換器連結48V及12V電氣系統層級。其中的對應元件包括感測器、微控制器、電源供應器、通訊及驅動器IC。

圖3顯示控制啟動器-交流發電機的半導體基本配置;啟動器-交流發電機是48V車輛電氣系統的關鍵元件。為了向微控制器供電,因此將系統電壓(48V)降低至微控制器及其他IC的一般程度。這是供電IC(安全系統供電)的基本功能,也可在功能安全領域執行其他作業。微控制器可實現電動馬達的場導向控制,以及在交流發電機運作時控制勵磁機繞組。微控制器為此實作複雜的計時器單元,並透過各種通訊匯流排(例如CAN)與車輛的其他控制單元通訊。

圖3 48V微型混合系統搭配主要半導體元件的方塊圖

如果使用適當的感測器,電動馬達轉子的轉子位置及旋轉速度,以及目前通過變頻器的電流,就可接受量測並傳輸至微控制器。智慧型感測器IC已經可以在內部處理量測資料,並透過感測器匯流排以數值方式將此項資料提供給微控制器。為了精準控制馬達,也必須將個別馬達相位的電流傳輸至微控制器,因此會在變頻器使用分流電阻器,或使用磁場感測器判定電流。

低損耗MOSFET通常在48V車輛電氣系統作為功率級IC,大多是以專屬的三相驅動器控制及監控,並可於緊急狀態時切換為安全狀態。除了馬達驅動器IC以外,其他重要元件還包括高效能閘極驅動器IC,可搭配MOSFET提供高度可靠的電池開關或安全開關,因應48V/12V隔離需求。48V車輛電氣系統以DC/DC轉換器與12V車輛電氣系統電氣耦合。

48V系統需慎選應用

半導體商如英飛凌(Infineon)為48V系統提供完整的晶片組系統解決方案,其中涵蓋穩壓器、收發器、感測器、微控制器、智慧型電源驅動器,乃至於電阻較低的MOSFET。

AURIX微控制器系列可謂成功,特別是動力傳動系統領域,不過也能因應其他領域需求,例如安全或駕駛輔助系統。同時最新一代AURIX TC3xx產品(40nm搭配嵌入式快閃記憶體)也正在生產,提供高效能及高效設計的所有要素。這樣設計人員就可選擇各式各樣的可擴充記憶體容量、周邊裝置功能、頻率、溫度及封裝選項。AURIXTC3xx系列採用多核心架構,包含六個獨立運作的32位元TriCore處理器核心,運算效能遠超過前代產品。該微控制器結合即時功能、資料安全及功能安全,能夠滿足最高ASIL-D的ISO 26262系統需求。

AURIX與TLF35584安全供電裝置是良好組合。外部安全裝置不僅提供電力,也能監控供電及微控制器的功能安全(例如看門狗),有時也負責在發生安全相關故障事件時,將系統切換為安全狀態(失效安全)。如此可提高系統可用性,同時也能個別設定微控制器的錯誤回應。48V系統的其他重要通訊及電源元件為隔離CAN收發器及橋接驅動器IC。

48V應用對80V及100V MOSFET具有高度需求,用於啟動器-交流發電機(皮帶驅動或整合式)、DC/DC轉換器或電池主開關等應用。而英飛凌OptiMOS5系列提供可擴充的低導通電阻器(最低1.2mΩ)產品組合及多種封裝,例如新型TOLL(TO無鉛)、TOLG(HSOG-8)、TOLT(頂端冷卻提供高效能)、裸晶及晶片嵌入。

同時,48V系統也需要精準強大的感測器,感測BLDC馬達的轉子位置,以及用於量測電流。基本上感測器占用空間應越小越好,具備低損耗、彈性及符合成本效益等特性,並在完整的服務壽命期間提供高度精準、強大及安全的運作。例如霍爾型電流感測器XENSIV TLI4971,是英飛凌新系列「無核心」電流感測器的首款產品,可因應前述所有需求,量測電流最高可達120A,經校正後可供貨使用。

晶片嵌入技術降元件/接合複雜度

如英飛凌與Schweizer Electronic AG也合作開發功率MOSFET晶片嵌入技術(圖4)。這項技術可提升最高60%的48V系統效能,同時降低元件及接合技術的複雜度。晶片嵌入技術的MOSFET,並不像之前一樣焊接至印刷電路板,而是直接整合,也就是所謂的標準單元,其採用銅製導線架的MOSFET裸晶。其中提供的相關熱能及電氣優勢,可大幅提升電源密度,同時也更為可靠,特別是在與陶瓷模組比較的情況下。這樣開發人員就能提升48V系統效能,或使其更具成本效益。例如整合式48V啟動器-交流發電機扮演重要角色,讓輕油電混合車排放的CO2比傳統傳動動力系統減少15%。

圖4 使用晶片嵌入可進一步提升35%的電源密度

依據本文所述背景及應用範例,針對車用48V車輛電氣系統電壓技術進一步投資及系統最佳化,無疑為合理作法。

(本文作者皆任職於英飛凌,Dusan Graovac為汽車系統工程部門總監暨全球負責人;Christoph Schulz-Linkholt為配電部門首席系統架構師;Thomas Blasius任職於汽車車體系統行銷部門)

ACAP助攻醫療超音波 合成孔徑/平面波成像效率增

本文介紹了如何運用先進成像方法,實現更優異的成像畫質、速度和準確性。平面波(PW)和合成孔徑(SA)成像是本文主要介紹的兩種方法,它們為心壁運動、血流和心臟外科手術等難以管理的特定診斷和外科手術帶來可觀的訊框率和準確性提升。

醫療需求推升技術更迭

不斷攀升的醫療成本正在成為醫院、診所和服務供應商的沉重負擔,因為他們需要確保為患者提供高品質的服務,同時更有力地控制成本。提高臨床治療中的患者流量是一種有望借助運算技術發展控制成本的途徑。與此同時,放射科醫生也強烈要求大幅提高醫療超音波、CT掃描器和其他類似設備等醫療成像設備的影像輸出畫質。

發揮人工智慧(AI)及其分支機器學習(ML)的作用,並將使用深度神經網路的ML方案用於輔助診斷和效率的提升,也是頗有前景的方法。這樣就能依靠新型晶片元件大幅增強的運算功能與演算法進步來改善畫質、組織識別、分類以及器官分割準確率,進而簡化臨床工作流程。

在各種臨床處理過程中,醫療診斷成像是發揮這種先進的運算技術的主要過程之一,因為聲波技術侵入較輕微且不涉及輻射。此外,與CT和MRI等其他方式相比,它的使用更普遍、成本更低、速度更快且尺寸更小。儘管過去數年裡已取得重大進步,但雖透過使用更快速的平行運算和AI演算法,診斷品質、準確度和速度仍有較大的提升空間。

本文針對醫療超音波設備製造商(OEM)介紹如何提高成像畫質、速度和準確性;與此同時,本文還介紹如何與深度學習演算法結合使用,並借助產品改善。對於本文的目標受眾(如開發醫療超音波成像系統的架構師和科學家),本文也介紹開發生產力的工作流程。

在過去二十年裡,兩種用於獲取和處理醫療超音波影像的新銳方法被研發出來—合成孔徑成像方法和平面波成像方法。這兩種方法與當前的順序慢速超音波成像方法截然不同,因為後者每次只能採集一行影像。新方法則可使用超音波穿透整個成像區域,因此一次發射就能重建完整的影像。成像速度達到每秒數千訊框。與這樣的訊框率同時實現的,還有全新的成像可能性,如更強的聚焦和穿透、向量流成像、功能超音波、超高解析度成像、高速心臟成像與量化等,同時可提升十倍的定量測量精度。

快速成像方案產生了比傳統成像高出幾百倍的處理需求,因此到目前為止阻礙了這些先進成像方法的實現。本文介紹了處理元件和新開發環境如何即時輕鬆實現這些先進的成像方法。如賽靈思(Xilinx)Versal自我調整運算加速平台(ACAP)元件與Alveo資料中心加速卡可部署在工作站或伺服器上,是實現SA和PW方法的硬體選擇。

與傳統的順序超音波成像相比,SA和PW成像方法具備一系列的優勢。主要在於採集的資料集完整,而且聚焦可在處理中合成,而非在採集過程中完成。因此,在發送和接收過程中都可以動態聚焦資料,獲得成像區域上的理想解析度,而傳統成像只能在發送焦點上實現最佳聚焦。這種功能被證明能提高體內成像畫質並增強穿透深度。

由於採集的資料集完整,這些成像方法也開啟追溯處理的廣泛應用。持續完整的資料獲取對成像也有很大幫助,其有利於不間斷地全向追蹤運動中的結構和血液。這樣能將速度估算精度提高十倍,還能估算速度向量;而長時間的觀察也有助於在腦功能成像中檢測較低流速。此外,資料流敏感度也提高,因此能檢測較低流速;而高訊框率則有助於檢測組織彈性和進行剪切波成像。

這些成像方法已與超音波造影劑結合使用,透過追蹤氣泡穿過最小血管的運動執行,以獲較高的超音波解析度,進而能夠區分尺寸小至10微米的結構。

因此,使用SA和PW超音波成像方法有助於開發全新的超音波應用,為提高運動估算的解析度、對比度和準確性鋪路。然而,成功實現即時應用依然被需進行的大量運算限制,但現在透過使用本文介紹的可編程設計元件及開發平台,該問題已迎刃而解。

一窺超音波成像採集流水線

採用壓電式轉換器的超音波系統將電傳輸脈衝轉換成超音波脈衝,並從電子訊號中接收超音波回波脈衝。這種轉換器採用大量壓電元件(32個到192個),可以根據所需的不同研究提供不同的形式和功能。最常用的B模式規格掃描線配置包括:(a)線性、(b)曲線、(c)梯形、(d)扇形和(e)放射狀。參見圖1。

圖1 常用B模式格式的掃描線安排

轉換器有以下選擇:線性陣列,能在更深層面實現身體和器官的表面區域成像;曲線和梯形形狀,用於腹部器官和產科掃描;扇形形狀,用於心臟成像(通常透過肋骨之間的狹窄聲學視窗進入);放射狀,用於血管內成像。

在繪製二維(2D)影像時,接收到的回波幅度與亮度(B模式)和回波穿過組織深度的時間有關。B模式使用多行成像,影像中每行用一個脈衝-回波序列產生,最終為被診斷的器官生成最終的解剖截面圖。有鑑於具體超音波轉換器的多個參數,可將超音波處理描述為一個多步驟序列,根據選定模態的功能,構成資料處理的單或多個並行流水線。

流水線示例如下所述:生成調製超音波脈衝,頻率取決於探頭類型、治療方法和成像模態類型。或是可激發轉換器的電以傳輸調製波,激發可包括發送器上的波束成形,進而選擇性發射聲波(Selective-in-sonification)、生成虛擬源,以及生成特定波前(球面波、平面波等)。

而轉換器亦可接收超音波觸及器官返回的回波,並轉換成電子訊號(RF資料),同時用時間增益補償均一化遠近回波,以便進行統一處理。同時,可針對接收訊號進行數位化處理,以透過波束成形,將接收到的訊號聚焦在特定深度,並使用來自多個單元的資料重建掃描線。

至於非線性(對數)壓縮級將回波動態範圍與人感知動態範圍進行匹配,也可透過插值創建表示物理尺寸的影像。此外,用於完成下列功能的其他數位訊號處理層級包括:

·減輕雜訊

·消除像差

·降低干擾

·消除掃描線偏移

·降低散斑

·提高解析度

·增大測量距離

·銳化邊緣

·減少偽影

SA/PW成像原理解析

在傳統的超音波成像中,首先將發射聚焦的超音波場域,然後用探頭的全部單元接收來自組織的散射訊號;接著使用影像中點到接收單元的幾何距離確定接收聚焦。將其表達成深度的函數即可實現動態化,進而確定最佳接收聚焦。然而,發送焦點被限制成單獨的發送焦點,影像只能在該深度上實現最佳聚焦。

這種局限性在SA成像和PW成像中得以緩解,此時成像透過發射一系列球面波或平面波來完成,如圖2所示。

圖2 SA成像(左)與PW成像(右)圖解

在圖2中,第一列所示是發射的球面波或平面波;第二列所示為每次發射產生的波束成形低解析度影像;最後一列是將所有低解析度影像按相位求和得到的高解析度影像。

接收聚焦方法與常規的成像方法相同,但發送聚焦是透過結合多次發射得到的資料進行合成。這就使發送聚焦具有動態性,能夠獲得穿過影像深度的最佳聚焦,進而強化整個影像的對比度和解析度。聚焦的具體做法是運算從發送來源出發,穿過成像點再返回接收單元的幾何距離。接著,再從接收到的轉換器訊號選取資料,針對樣本數值進行插值後求和。這個求和操作也稱為相複合,尤其是在PW成像中。除了發送來源到成像點間的距離略有差別以外,SA成像和PW成像的距離計算相同。因此,兩種成像方法可使用相同的處理架構。

次要優勢在於發射次數與成像行數無關。傳統方法必須完成200次發射才能採集完整的高解析度影像,而SA成像和PW成像需要完成的發射次數要少得多。一般情況下,1到8次發射即可完成成像流、執行10到30次就能完成較佳的B模式成像,因此可提供較高的訊框率,進而產生前述提到的諸多優勢。具體如圖3所示,該圖表示一定發射次數下,成像對比度與以波長為單位的成像深度之間的關係。若數量越小越好,因為這說明圍繞主峰的旁瓣數量少;而增加發射次數能夠增大對比度,但12次發射後不再進一步提升。在本示例中,這決定了對比度和訊框率之間的最佳權衡取捨。此外,4到8次發射也能提供良好的對比度,足供要求較低的成像流使用,因而有助於提高訊框率。

圖3 使用以λ/2為間距的192元線性陣列探頭,一定發射次數下成像對比度與以波長為單位的成像深度之間的關係

兩種成像方法只需要少量發射就能在整個興趣區域內持續成像,是成像流的選擇之一。此外,上述成像方法還能在各方向上持續追蹤移動物件,專為估算主動脈中的血流、檢測組織的運動與彈性,以及實現較低速流檢測而開發。這是因為有連續資料可用,同時透過使用更先進的濾波器來分離流和組織,得到的影像不僅具有更高的動態範圍,且對低速流的靈敏度也有所提高。

影像實現獨立運算

在SA/PW系統中持續完成的波束成形操作次數由下列公式決定:

其中Nl是影像行數,Ne是接收元數,f0是轉換器中心頻率。採樣以探頭中心頻率的四倍頻率進行,透過強化奈奎斯特採樣,實現線性成像。因數k是用於成像的時間分數。為大幅提高訊框率,k值大約在0.8到0.9之間;但如果為降低處理需求而使用較低訊框率,也可以選取非常小的值。

典型取值如Nl=200、Ne=192、k=0.8和f0=5kHz,每秒完成614千兆次運算。一般情況下,完成一次波束成形運算包括運算聚焦延遲、變跡值,最後對樣本值進行插值,並將其與來自轉換器其他單元的數值相加。總體上,每次波束成形運算需要完成30到100次運算,全即時SA成像和PW成像每秒可完成太次運算。與常規系統相比的不同之處在於,完整影像是一次性重建,而不是每次脈衝發射繪製一行,而且出於這個原因,此類系統中的運算量也提高Nl倍。主要優勢在於影像中的各點都能獨立運算,因此,處理在本質上擁有並行性,適用於FPGA實現方案。

受處理資源的限制,PW成像和SA成像直到最近才得到採用。現在由於Versal ACAP等新興嵌入式處理平台的推出,即時實現此類技術才變得切實可行。

插值為影響成像產生關鍵

獨立單元往往以λ/4的速率進行採樣,這符合奈奎斯特(Nyquist)定律,但不足以實現極低延遲。插值是一種補償缺失點的簡便方法。插值器的品質是減輕「虛擬」樣本產生負面影響的關鍵因素。此外,插值器也是對運算能力要求極高的一項功能。在圖4中,部分插值器使用它們的PSF等等值線圖進行比較,等值線間距離為6dB,直至-60dB。合成孔徑使用FieldII模擬器對3.5MHz線性陣列128元探頭進行模擬,採用λ/4採樣,每128單元作為一個發射器。

圖4 用於128元線性陣列探頭插值方案的點擴散函數

圖4所示為插值效果。左上圖所示為在樣本之間使用線性插值時的點擴散函數。右上角所示的是採樣頻率提高10倍與線性插值相結合時的interp函數。左下角是採用樣條插值的情況,右下角則是使用了分段三次Hermite樣條插值多項式pchip。只為樣條函數和interp函數獲取合適的旁瓣,這體現插值對高品質成像的重要性。

合成孔徑/平面波成像使用軟體面臨挑戰

SA成像和PW成像面臨的根本挑戰在於,如何就每秒產生的資料量與特定處理成像流水線中的可用算力進行平衡。超音波成像系統可劃分為前端(FE)、影像成像器(IF)和後端(BE)。FE負責管理轉換器、發送脈衝生成(TX)、接收類比訊號(RX)和TX/RX相位開關矩陣(SM)的硬體方面。影像成像器負責波束成形,有時該功能也被分配到FE。BE負責增強影像,將其從聲學掃描網格轉換為顯示網格,然後進行渲染和顯示。近期,IF和BE通常直接使用原始資料在軟體中進行結合。這種方法需要多條一般使用PCIe的高速傳輸通道,用來將原始資料傳輸到搭載高性能CPU和GPU的工作站。由於多條傳輸通道、緩衝存放區原始資料、向CPU快取和GPU板載記憶體傳輸資料等原因,從FE向BE傳輸大量資料會造成額外的時間延遲。對於擁有128條通道的高階系統來說,在40MHz RF取樣速率下運行,且每樣本以12位元進行編碼,並以1540m/s聲速,在7.7cm深進行軸向成像,每個TX脈衝事件產生的原始資料大小是2,212MB。

如果要實現更高解析度,使用快速成像以每秒15,400次的頻次重複脈衝,產生的資料傳輸量為18.8GB/s。就算是PCIe Gen3x16這樣可提供約12GB/s傳輸速率的整合模組,也無法滿足BE所需的傳輸速率。BE必須將原始資料的儲存速度和傳送速率提高數倍,才能將資料提供給CPU進行控制,同時提供給GPU進行演算法處理。由此引發的時間延遲程度也會限制即時性能。這就需要高速傳輸巨量資料,並在可能的情況下儘早處理資料,以減輕資料負擔。

ACAP促SA/PW成像性能提升

超音波系統本身較適合採用異構運算架構。FE是高度模擬的,如圖5所示。Versal ACAP則用於模擬前端(AFE)控制和資料(RF資料)儲存。

圖5 FE簡化原理圖

Versal ACAP可提供LVDS,負責接收來自AFE的輸入資料,為資料泵和資料獲取提供正確的時鐘與設置,管理發送器的啟動與TX和RX之間的開關。所有這些階段都需要在主類比硬體與Versal ACAP中的可編程設計邏輯之間進行高強度交互作用。這並非易事,但ACAP是解決它的良好選擇。超音波流水線的剩餘部分則用於處理採集的RF資料,而圖6則專注於波束成形流水線。

圖6 用於SA成像和PW成像的波束形成流水線

波束成形是高度並行的演算法。在波束成形器內形成影像的每一步都可以描述成一個資料流程操作,其中分階段處理RF資料,每個階段隨後流入到下一階段。在運算架構中,資料流程由節點構成,形成按佇列連接的圖形。資料流程模型提供流水線並行性,圖形表示的是應用流或程式流,節點表示對資料應用的函數。

圖6所示的是波束成形,方框表示處理階段(操作),線條表示連接器,其中兩個灰色塊表示迴圈("for_loop")。

資料流程能將資料細分,進而將運算流程劃分為並行流,如圖7所示,進而大幅提升性能。

圖7 資料流程圖的橫向劃分(迴圈展開)

ACAP架構實現SA/PW成像資料流程

在傳統微處理器上實現超音波模態資料流程會產生與並行性和資料輸送量有關的問題。350fps下「B-模式」需要大約6.08 Gmult/s的延遲和變跡值運算量。樣本插值需要的運算量在12.17Gmults/s,波束成形器需要的運算量大約在3,028Gmult/s。它類似於僅有30fps的「流模式」,所有運算都透過單精確度浮點運算完成。

一般來說,這樣的運算量難以在嵌入式平台上實現,至少需要高性能桌上型電腦或是電腦叢集。在表1中,便將CPU的理論峰值性能與上述要求進行比較。

此外,在從DDR記憶體(DRAM)向處理器傳輸大型資料叢集(如本應用所示)時,大量資料超過快取極限,導致與其他核心干擾相關的額外限制因素,理論上來說,性能下降幅度最高可達10倍。參見圖8。

圖8 使用快取的傳統多核心架構

如果驗證過諸如SA和PW等運算密集型問題的基本演算法本質,則有一個更好的選擇。SA和PW波束成形適合用線性代數運算來表示。掃描線可以由一個向量、一組帶矩陣的掃描線、一組帶矩陣或立方體的轉換器掃描線,或一組帶立方體向量的發射集表示,具體參見圖9。這類表示屬於張量,如同深度神經網路使用的類型。

圖9 SA與PW波束形成的張量表示

若使用具備下列重要特性的架構,能夠高效運算張量、內積、外積、向量-矩陣相乘、矩陣-矩陣相乘、濾波器、卷積和離散傅里葉變換:

·以棋盤格(拼圖模組)結構組織的同構處理器單元集合

·一套用於連接處理器單元的開關網格;該開關網格是用資料路徑連接及可編程設計開關構成的規則結構

·用於編排資料流程的控制器

·演算法的局部開發,即資料移動通常限制在相鄰處理單元範圍內

·使用流水線技術實現處理器單元的高利用率

如Versal ACAP採用使用拼圖模組的AI引擎架構,能夠滿足上述要求。拼圖模組中的處理單元採用單指令多資料(SIMD)和超長指令字(VLIW)架構。參見圖10。

圖10 AI引擎陣列

AI引擎整合一個標量單元、一個向量單元、兩個負載單元、一個儲存單元和一個記憶體介面。標量單元則整合一個32位標量RISC、一個32×32位標量乘法器,同時可支援正弦/餘弦、平方根、平方根倒數等非線性函數。向量單位整合:512位元向量定點/整數單元和單精確度浮點向量單元,均支援多個向量通道上的併發運算。每個AI引擎內建專用的單埠16KB程式記憶體。

每個AI引擎方塊圖內建32KB資料記憶體,其劃分為八個單埠組,允許每個時鐘週期最多八個並行記憶體訪問事務。

此外,資料記憶體還內建DMA邏輯,可支援輸入到本機存放區器的傳入流,從本機存放器向外輸出的傳出流,以及本機存放區器中的緩衝流。透過支援二維跨越式存取,任何AI引擎都能存取各方向上相鄰AI引擎方塊圖中的資料記憶體,進而允許單個AI引擎存取高達128KB的資料記憶體,每週期存取四個記憶體模組,頻寬超過1太位元組/秒。參見圖11。

圖11 AI引擎方塊圖

從運算角度,每個AI引擎方塊圖都具備乘法-累加處理能力,如圖12所示。

圖12 以週期計的乘法-累加性能

「B-模式」的性能要求估計在3,200 Gmult/s左右;因此根據圖12,在1GHz下,每個方塊圖能夠每週期執行8MAC,因此需要3,200/8=400個方塊圖。

從宏觀上看,AI引擎能夠實現SA和PW中資料流程演算法所需的所有不同結構。作為參考,在圖13中,除了AI引擎以外,Versal ACAP整合的特性還包括一個標量引擎、自我調整引擎(可編程設計邏輯)、智慧引擎(由AI引擎和DSP引擎共同構成)以及一個可編程網路單晶片(NoC)。

圖13 Versal ACAP原理圖

雙核心Cortex-A72 64位元處理器用於託管作業系統(如Linux)以及執行與控制超音波處理有關的任務。該處理器為連接、編排和更新提供所需的一切功能,還為超音波採集所需的數位訊號處理提供豐富的基礎設施。

自我調整部分(可編程設計邏輯)負責一切與採集有關的功能,其中包括控制AFE、發送器,解調來自轉換器的I/Q訊號。此外,它還能為特定任務加速並對已採集資料從記憶體到AI引擎的傳輸進行管理。

如Versal ACAP的可編程設計NoC是一種完全整合的高速全獨占式縱橫開關,用於管理SA成像和PW成像所需的高頻寬。NoC的作用在於實現對全高全寬PL的無縫記憶體映射存取,以便連接元件上需要使用大量資料的區域。它能夠:

·針對DRAM實現共用設備存取

·在PL之間建立連接

·對AI引擎陣列進行記憶體映射存取,以便進行追溯和調試

·在PS、PL和AI引擎陣列之間建立連接

·在PS和DDR記憶體之間建立連接

程式設計用於SA/PW成像AI引擎

AI引擎程式由使用C++編寫的資料流程圖規格構成。該規格可以使用專用編譯器編譯並執行。資料流程圖由節點和邊緣構成,其中節點表示運算核心函數,邊緣表示資料連接。

資料流程圖的核心在資料流程(無限長的類型值序列)上運行。這些資料流程可以被分解為單獨的方塊圖,而這些方塊圖由核心進行處理。核心消耗輸入資料方塊圖並產出輸出資料方塊圖。此外,核心還可以逐樣本地存取資料流程。

AI引擎核心是一個指向VLIW向量和標量處理器的C/C++程式。

包括記憶體通訊和串流通訊在內,存在多種可能的通訊配置,它們都是SA成像和PW成像的必要構建方塊圖。參見圖14。

圖14 AI引擎通訊結構

消耗輸入資料方塊圖的核心被稱為輸入視窗,產出輸出資料方塊圖的核心被稱為輸出視窗。二者由AIE編譯器根據資料流程圖連接自動完成推斷。

核心接收類型資料的輸入流或輸出流作為參考。PS可用於動態載入、監測和控制在AI引擎陣列上執行的資料流程圖。AI引擎架構和編譯器彼此配合,提供程式設計模型。兩個流連接能夠以透明方式共用同一物理通道,前提是它們的總通道占用率未達到100%。除了在AI引擎的處理器單元上運行以外,核心也能指定核心在PL上運行。圖15所示的是SA成像和PW成像的概念圖。A區方塊圖將PL連接到B區的PL核心方塊圖,後者又流到C區的核心,進行延遲運算。一套核心隨後並行啟動並交替執行,交替的核心數決定並行程度和加速程度。隨後,波束成形核心產生實體其他內部核心,用於D區方塊圖所示的內部運算。E區核心將波束成形資料流程到DDR記憶體。

圖15 SA和PW波束形成器的完整資料流程圖結構

合成孔徑成像與平面波成像技術可以使用Versal ACAP與AI引擎以及相關的軟體框架實現,為此類先進的超音波模態提供單晶片實現方案。對於先進的超音波系統,則可以使用單片以上的Versal ACAP,借助128個轉換器實現高達2,000訊框/秒的良好性能。

(本文由賽靈思Xilinx提供)