ML

人機介面技術大突破 蘋果申請AR觸控專利

近日蘋果(Apple)為搭配擴增實境(AR)使用的觸控技術申請專利,未來蘋果的AR眼鏡可望減少使用者原先對觸控面板的依賴。根據專利申請文件,蘋果已發展出透過機器學習(ML)與深度地圖鏡頭(Depth-mapping Camera),測量物體觸碰虛擬螢幕的距離,並進一步辨識輸入內容的特殊觸控技術。

蘋果擴增實境APP─ARKit 2。

針對AR的觸控輸入,蘋果透過三個鏡頭初步確認手指輸入的位置變化,建構出三維深度空間,同步搭配機器學習的模型訓練與深度地圖鏡頭,辨別手指的輸入位置、時間和輸入意圖,並能將觸控螢幕固定投影到牆壁或其他平面上。AR觸控技術除了未來AR眼鏡的應用,即將發售的新iPad Pro也將搭載類似的多鏡頭配置。

蘋果在2017年首度提出該專利的申請文件,並附上圖片與實際測試結果,顯見此一專門搭配AR使用的觸控技術並非只是理論,而會應用在未來的產品之中。蘋果執行長Tim Cook曾表示,AR技術是公司的重要業務,並已規劃好接下來發布AR眼鏡的時間表。

貿澤攜手NXP出版電子書探索AI潛能

貿澤電子(Mouser)日前宣布與恩智浦(NXP)合作出版最新的電子書,書中將探索人工智慧(AI)無窮的發展潛能以及幾款針對AI和機器學習(ML)解決方案的特定產品。在Imagine the Possibilities(讓想像力無盡延伸)這本電子書中,貿澤與NXP的專家針對包括語音控制、臉部辨識、自動駕駛和物體辨識等熱門且敏感的AI應用提供了深入的分析。

近來在AI和ML領域的發展,為技術、產品和產業帶來許多突破性的革新。隨著高效能處理能力從雲端移轉到邊緣,對頻寬的要求下降後,讓工業、汽車和物聯網 (IoT) 等應用有機會開發出全新的解決方案。貿澤與NXP所出版的最新電子書闡述了AI和ML目前的狀況,同時也強調產業未來的走向和解決方案。

Imagine the Possibilities這本書中也詳細介紹了一些產品,例如NXP的S32V2視覺處理器、Layerscape通訊處理器和i.MX 8M應用處理器。NXP的工程師與產品專家提供了如何將AI運用到各行各業的寶貴秘訣與資訊,另外也指出想要設計成功的解決方案所需要的步驟和元件。本電子書所收錄的文章還談到了內含推理引擎、神經網路編譯器和最佳化程式庫的NXP eIQ ML軟體開發環境,另外也談到Layerscape軟體開發套件(SDK),能夠提供多功能平台讓開發人員測試不同的AI/ML軟體組合。

Arm新AI技術使物聯網終端裝置更智慧化

Arm日前宣布其人工智慧(AI)平台新增重要生力軍,包括全新機器學習(ML)矽智財、ArmCortex-M55處理器、Arm Ethos-U55神經網路處理器(NPU),這是針對Cortex-M平台推出的第一個微神經網路處理器(microNPU),這樣的設計(Cortex-M55結合Ethos-U55)為微控制器帶來480倍-跳躍式的機器學習效能。全新的矽智財與搭配的開發工具,可為數十億個小型、低耗電的物聯網與嵌入式裝置,帶來終端機器學習處理能力,並得以讓AI的硬體與軟體開發人員能以更多的方式進行創新。

Arm 資深副總裁暨車用與物聯網事業部總經理Dipti Vachani表示,要讓AI無所不在,裝置製造商與開發人員,必須為數十億、乃至於最終數目達到數兆個裝置,帶來終端的機器學習能力該公司的AI平台增添這些生力軍後,即便在最小的裝置上,終端機器學習即將成為新的常態,因此再也沒有任何裝置會是遺珠之憾,而這也讓AI的潛力在範圍寬廣,並在那些且足以改變人們生活的應用當中,充份且有效地發揮。

Arm 透過新的設計為微處理器帶來智慧,降低半導體與開發成本,同時為想要有效提升終端數位訊號處理(DSP)與機器學習能力(ML)的產品製造商,加快他們產品上市的速度。

Cortex-M處理器已經成為開發人員運算平台的最佳選擇,而Arm的合作夥伴也針對各種的客戶應用,出貨超過 500 億片基於Cortex-M的晶片。新增的Cortex-M55,為Arm歷來AI能力最強大的Cortex-M處理器,它同時也是第一個基於Armv8.1-M 架構、並內建ArmHelium 向量技術,可以大幅增加DSP與ML效能,同時更省電。與前世代的Cortex-M處理器相比,Cortex-M55 的ML效能最高可提升 15 倍,而DSP效能也可提升五倍,且具備更佳的效能比。

此外,客戶也可以使用ArmCustom Instructions(客製化指令)延伸理器的能力,對特定工作負載的優化,而這也是Cortex-M處理器的全新功能;針對需求更高的ML系統,可將Cortex-M55 與 Ethos-U55 搭配,後者是Arm第一個微神經處理器(microNPU)。兩者結合後與現有的Cortex-M處理器相比,ML 效能可以大幅提升 480 倍。

Ethos-U55具有高度的可配置性,同時也是專門設計用來加速空間受限的嵌入式與物聯網裝置的ML推理能力。它先進的壓縮技術可以節省電力,並顯著縮小ML模型尺寸,以便運作之前只能在較大型系統上執行的神經網路運算。

賽靈思為專業影音暨廣播平台導入ML功能

賽靈思(Xilinx)日前宣布旗下針對專業影音(Pro AV)與廣播市場的元件導入全新的先進機器學習(Machine Learning, ML)功能。同時也向展示首款基於7奈米Versal元件的可編程HDMI 2.1解決方案。賽靈思將在阿姆斯特丹的2020歐洲整合系統展(Integrated Systems Europe, ISE)展示這些功能與其他的解決方案。上述這些技術和其他針對專業影音與廣播市場的賽靈思高度自行調適解決方案,希望在跟上新型使用模式與產業標準持續演進的同時,協助客戶降低成本並投資未來。

賽靈思專業影音與廣播事業總監Ramesh Iyer表示,ML是一項快速發展的技術,其在專業影音與廣播領域中激發出嶄新的應用模式。賽靈思將ML導入自行調適平台中以提供高度整合的AV處理器,為8K影片、網路音訊視訊傳輸系統(Audiovisual Over Internet Protocol, AV-over-IP)與壓縮(Compression)提供經得起考驗的支援。現在更增添用於分析獲利、提高作業流程效率與增強使用的先進功能。上述整合式ML功能最終能使企業推動創新研發、發展差異化並加速產品上市的時程。

賽靈思針對專業影音與廣播平台新搭載的ML功能,包含感興趣區域編碼(Region-of-Interest Encoding)、智慧型電子看板(Intelligent Digital Signage)、自動化物體追蹤與視窗裁切(Automated Object Tracking and Window Cropping)與語音辨識等(Speech Recognition)。客戶可利用賽靈思元件所搭載的眾多ML功能,包含高度整合的Zynq UltraScale+ MPSoC平台來執行AI邊緣運算。將即時音訊與視訊處理、AV連結介面、編解碼器、IP網路、CPU、GPU等諸多功能整合的自行調適與可擴充單晶片解決方案,能協助客戶省下可觀的空間、功耗與成本。

AIoT熱潮有增無減 邊緣運算方案競出籠

人工智慧(AI)蓬勃發展,而AI結合AIoT更是現今半導體產業熱門議題。IoT產品除了要能聯網,同時也須更智慧化,才得以實現更多創新應用;而要讓終端設備變得更智慧,無疑是為其增添AI,這也意味著終端裝置須具備更高的運算效能,才得以在終端先行處理龐大的資料量。為此,邊緣運算(Edge Computing)形成時下主流,各大AI方案供應商也加強布局力道,邊緣運算的軍備競賽可說如火如荼的進行中。

Arm新NPU/GPU系列提升智慧沉浸體驗

從遊戲裝置到數位電視(DTV),人工智慧現在已經無所不在;但考量到要促成這些回應式的體驗,端點必需具備更強的運算能力。例如,數位電視的智慧型體驗,包括智慧助理語音指令、節目即時翻譯至另一種語言及人臉辨識以強化家長監護。

為了達成這些功能,Arm宣布推出兩個全新的主流機器學習(ML)處理器,分別為Ethos-N57與Ethos-N37 NPUs;以及最新的Mali繪圖與顯示處理器Mali-G57 GPU。新推出的兩款ML處理器,可實現AI應用並在ML的效能與成本、面積、頻寬與電池壽命限制之間達成平衡,而Mali-G57 GPU則是第一個以Valhall架構為基礎的主流GPU,可透過效能提升帶來沉浸式體驗。

Arm資深副總裁暨車用與物聯網事業部總經理Dipti Vachani(圖1)表示,該公司致力於投注領先全球的前瞻技術,全面賦能運算效能,實現更多創新體驗。除了上述新推出的ML處理器與GPU外,該公司也針對全球一兆台聯網裝置打造支援bfloat16功能以強化終端裝置機器學習的Neoverse平台,將AI導入邊緣運算,在終端及雲端發揮數據價值。

圖1 Arm資深副總裁暨車用與物聯網事業部總經理Dipti Vachani表示,Arm希望透過完善的產品線與解決方案,滿足日漸增加的沉浸式體驗需求。

Vachani補充,除此之外,因應運算從雲端移至邊緣,該公司也推出能確保雲端原生體驗的Project Cassini解決方案,實現從雲端到終端皆具備完善的智慧運算決策能力,以應付更多元且多變的應用場景。這些方案加總起來,代表Arm有能力依需求調整規模,並把優質的體驗帶入消費者的日常生活裝置中。

據悉,在Arm ML處理器(現在稱為Ethos-N77)發表後,Ethos-N57與Ethos-N37是Ethos NPU系列最新的成員。Ethos為解決複雜AI與ML運算挑戰的產品組合,以便為日常生活裝置創造更為個人化與沉浸式的體驗。

由於消費裝置愈來愈智慧化,因此,透過專屬的ML處理器提供額外的AI效能與效率,有其必要性。為此,全新的Ethos NPU不僅針對成本和電池壽命進行優化,像是先進的資料管理技術,以減少資料的移動與相關的耗電,還進一步強化Int8與Int16資料類型的支援性,並透過創新技術Winograd,讓效能更上一層樓。

至於Mali-G57,主要目的是將優質的智慧與沉浸使用者體驗帶到主流市場,包括高傳真遊戲、媲美電玩主機的行動裝置圖型效果、DTV的4K/8K使用者介面,以及更為複雜的虛擬實境與擴增實境工作負荷。該產品和前一代Mali-G52相比,各種內容都能達到1.3倍的效能密度,且能源效率提升30%使電池壽命更長,以及針對虛擬實境(VR)提供注視點渲染支援且裝置上ML效能提升60%,以進行更複雜實境應用。

Vachani說明,遊戲體驗是行動裝置市場一項重要應用,除了推出效能更高的Mali GPU之外,該公司近期也宣布與Unity擴大合作,藉由將Arm的解決方案放置在Unity平台,讓遊戲開發者可以輕鬆的運用,創建更佳的沉浸式體驗。

布局高效運算市場 SiFive再發新IP組合

不讓Arm專美於前,SiFive近日也於Linley Fall處理器大會上推出全新高性能IP產品組合,其分別為SiFive U8系列核心IP和經過優化的HBM2E+解決方案,滿足各應用領域(如汽車、人工智慧、物聯網等)等終端運算需求。

SiFive首席執行長Naveed Sherwani表示,全新SiFive U8系列微架構的推出是一個重要的里程碑,可擴展的亂序RISC-V處理器可滿足汽車、資料中心和邊緣AI等需求。新推出的IP基於RISC-V指令集架構,是一種超純量(Superscalar)設計,具有可擴展的亂序執行通道(Out-of-order Pipeline)以及可配置的選項,供即時或應用處理器使用,滿足用戶對高效能運算產品的訂製需求。

另外,SiFive U8系列提供每瓦特超過1.5倍的面積效率和性能,而且擁有可運行Linux作業系統的記憶體管理單元,以支援通用應用處理器設計,以及用於關鍵任務操作的即時模式。同時,該產品具有可選的浮點單元、訂製的指令擴展功能和RISC-V向量擴展支援,使其無論是在汽車、AI邊緣或終端應用程式,都可以針對應用案例進行相應的配置和訂製。

至於SiFive HBM2E+ IP,則用於支援運算密集類型的工作負載,包括高性能運算、資料中心和邊緣AI設備中的深度學習處理,不僅易於整合至各式新設備中,並能使用可擴展的介面支援Chiplet設計和性能,進一步優化CPU到記憶體的路徑。

此外,SiFive HMB2E+解決方案已通過先進的7nm技術驗證,可提供高達400Gbps的記憶體頻寬,也就是每個引腳高達3.2Gbps的傳輸速率。與類似容量的DDR類型記憶體相比,HBM的堆疊特性不但占據較小的空間(可實現更小體積),且能達到更低功耗,且擁有更高頻寬,十分有利於處理密集的深度學習運算。

簡而言之,隨著人工智慧開始往邊緣發展,本地資料處理的效率和速度也須大幅提升,而SiFive新推出的處理器核心與記憶體介面相結合,可滿足各式高運算應用,例如資料中心、汽車系統、工業物聯網(IIoT)、消費性產品等。

NVIDIA新處理器體積/功耗/效能三者兼具

另一方面,NVIDIA則是推出Jetson Xavier NX(圖2)。該產品不僅具備高效運算能力,同時也具備超小體積,其模組尺寸比一張信用卡還小,在運行現代AI作業時可提供高達21TOPS的伺服器等級運算效能,而耗電量僅10瓦,可用於機器人和邊緣嵌入式運算裝置。

圖2 Jetson Xavier...

具高效/低功耗優勢 PIM技術重返深度學習熱潮

而所謂的記憶體內處理器(Processor In Memory, PIM)(圖1),或稱記憶體鄰近處理器(Processor Near Memory, PNM)、記憶體內運算(In-Memory Compute, IMC)等,則是在晶片電路設計時即以記憶體的矩陣記憶電路為基礎,再行加搭起運算電路,使記憶與運算電路幾乎融為一體。

圖1 左圖為現行處理單元與記憶體間有讀寫(Fetch提取、Store存入)的瓶頸,右圖為PIM作法可消除運算與儲存間的傳輸瓶頸。

資料來源:IBM

PIM作法過去曾在上世紀90年代倡議過但未能成為潮流,但隨著人工智慧(AI)、機器學習(ML)、深度學習(DL)的興起,產業界重新評估與發展PIM技術及晶片,原因主要在於現行主流技術在運算效能提升上漸遭遇多項瓶頸,難以因應日益增高的深度學習運算量。

首先是晶片設計團隊逐漸難從處理單元的邏輯設計上獲得更高效能,因此IBM POWER(Performance Optimization With Enhanced RISC)架構處理器於1999年首次運用持續推進的半導體製程縮密技術,於單一晶片實現雙核心,以增加核心數獲取顯著效能提升,2005年AMD於x86架構上實現雙核,自此處理器紛改以增加核數為主要效能提升手段。

多核作法之後亦遭遇瓶頸,即處理單元(核)間的資料交換不夠快速,溝通協調成為運作瓶頸,因此改進晶片內外的連接傳遞方式成為重點,此時經常出現晶片商強調結構織法(Fabric)一詞。

改善連接結構後仍有其他問題需解決,因漏電流因素晶片運作電壓難以再下降,即便晶片放入更多的核,也無法讓所有的核均全速運作,因供電散熱之限只允許部份的核全速運作,部份之外的核須以降速、輕負荷方式運作,或暫時關閉停止運作,此稱為暗矽(Dark Silicon)限制,當製程技術持續提升,晶片內的核數愈多,暗矽限制也會更嚴重(圖2)。

圖2 電路運用率撞牆,暗矽效應阻礙使多核處理器無法全速運作。

資料來源:Michael Bedford Taylor

另外記憶體與處理器間的傳輸通道也難以更快,記憶體電路區塊與處理單元區塊有別的結果,傳遞過程必然有一段電路距離,因電路上的寄生電容因素而難以更快速傳遞,形成馮紐曼瓶頸(Von Neumann Bottleneck),半導體製程縮密技術讓記憶體容量愈來愈大,但進出處理單元的資料通量卻沒有相應的提升。

深度學習運算量大增 PIM技術動向受矚目

而如前述,深度學習需要的運算量不斷提高,特別是在支援自駕車應用上,2017年NVIDIA提出自駕車運算平台DRIVE PX PEGASUS,宣稱合併兩張DRIVE PX PEGASUS可獲得320TOPS(8位元整數)的人工智慧推論運算力,目標在於支援ADAS標準最高的Level 5自駕層級,即各種路況與情境下均能全程自動化駕駛不需人為介入,然代價是500瓦功耗,對汽車電瓶亦是不小負荷。

由於傳統方式提升運算(特別是深度學習運算)效能日益困難,因此產業開始嘗試回望PIM技術。PIM技術因記憶電路與處理電路兩者緊鄰,傳輸距離短,可快速傳遞運算,而深度學習所需要的「網狀層次連接、節點加權運算」亦容易以PIM方式實現,記憶體內儲存的資訊即是節點的權重(Weight,或稱特徵權重),運算後的結果再向更深層的節點傳遞,進行相同的乘積累加運算(簡稱乘加運算Multiply...

工業+AI發展潛力大 訓練資料集建置仍為瓶頸

然而,對製造業應用而言,目前以雲端資料中心為基礎的人工智慧,通常是不符合需求的。在生產現場,絕大多數的控制命令跟判斷,都有很強的即時性,如果要把資料上傳到雲端,在雲端進行推論,再從雲端向現場機台下達控制命令,在時效上往往拖延太久。因此,直接在網路邊緣節點進行推論,將是面向工業應用的人工智慧所實行的主流架構,也就是俗稱的邊緣運算或AIoT(AI+IoT)。

這也使得有意進軍工業市場的人工智慧晶片業者,諸如NVIDIA、英特爾(Intel)與賽靈思(Xilinx)等,紛紛推出低功耗、低成本,適合部署於生產現場的晶片解決方案,如NVIDIA的Jetson TX系列、英特爾的Movidius系列、Cyclone/Stratix FPGA,以及賽靈思的Zynq 7000與部分Zynq UltraScale+系列晶片,都可讓部署在現場的嵌入式設備直接進行推論。這三家領導晶片所提供晶片方案,也正好代表了AI運算晶片的三大流派--GPU、ASIC與FPGA,在應用開發上各自有其優勢與限制。

GPU應用開發速度最快 開發工具/IP限制卻不少

對人工智慧應用的開發者來說,GPU是用來快速創建原型跟驗證設計概念的不二選擇。因為開發者只需要撰寫程式碼、甚至直接套用開發工具裡面的現成模型,稍微調整一下參數,就可以讓GPU開始進行訓練跟推理。因此,在應用開發的早期階段,GPU是目前最理想的選擇。

然而,GPU的成本高,功耗也偏高,是許多工業設備製造商在AI軟體發展完成,設備準備量產時,繼續沿用GPU做為系統核心的主要疑慮所在。GPU的散熱對於在工業環境下運作的嵌入式設備,是一個很大的問題。工業環境的溫度變化大,且現場往往沒有空調設備。如果環境的背景溫度本身就偏高,在這個情況下,採用被動式散熱的效果將大打折扣。

採用主動式散熱,例如散熱風扇,則意味著設備的機構設計可能需要保留開口,這會對設備的防水防塵能力造成負面影響。此外,某些工業環境中還有大量粉塵存在,如果設備內有風扇,不僅容易故障,還有引發粉塵爆炸的風險。

也因為上述種種環境條件的限制,GPU若想應用在工業設備上,低功耗是最重要的規格。散熱功耗(Thermal Power Dissapation, TPD)低於10瓦是設備得以採用被動式散熱的基本門檻,但如果能做到更低,工業設備採用GPU的疑慮也會跟著減少。這也是NVIDIA的第一代Jetson TX將功耗定在10瓦,並將新推出的Jetson TX2(圖1)功耗進一步壓低到7.5瓦的主要原因。

圖1 GPU的散熱問題是嵌入式應用開發商在選用GPU時最主要的疑慮之一。

除了功耗跟散熱問題外,GPU廠商的開發工具、參考設計跟協力廠商軟體資源雖然已經相當完整,但如果設備製造商想在這個基礎上進行客製化開發,還有智財(IP)方面的問題必須克服。有業界人士指出,跟NVIDIA合作,會受到很多限制。該公司提供的模型跟演算法資源相當豐富,也有為數眾多的協力廠商夥伴,但這些資源的智財權均控制在NVIDIA及其合作夥伴手上,如果要在產品上使用這些演算法,除了有可能需要額外支付權利金,NVIDIA對晶片的用途管控也相當嚴格。

另外,工業設備所使用的演算法跟模型,如果需要客製化調整,也可能需要跟演算法的開發者或GPU供應商進一步洽談,設備供應商不能自行隨意修改,這也是另一個潛在的成本來源,可能需要額外支付更高的權利金,或是耗費更多時間。

不過,倘若功耗跟智財都不成問題,對工業設備開發商來說,直接在設備上使用GPU,是最快將產品推向市場的途徑,因為產品從開發到最終量產使用的是同一個平台、同一套源碼,相容性基本上可以保證,不用擔心原本在GPU上開發的軟體,換到FPGA或ASIC之後會出現相容性問題。

ASIC算力/功耗比最優 演算法綁定不利發展多樣化應用

自從人工智慧浪潮興起後,許多IC設計公司都推出神經網路處理器(NPU)或ASIC加速器,想分食人工智慧應用的市場大餅。這些專為某些特定演算法或模型提供加速的晶片,在執行對應演算法的時候,有非常高的能源效率,功耗5瓦、甚至2瓦以下的解決方案都已經出現在市面上,為人工智慧應用的普及做出重要貢獻。

不過,也因為這類NPU或ASIC加速器只專門針對特定演算法或模型做優化,因此其泛用性很低。如果工業設備製造商對演算法或模型的更動幅度較大,甚至想套用自己發展出來的演算法,在這類平台上不是執行效果不佳,就是根本無法執行。

舉例來說,目前這類泛ASIC解決方案,最主要的應用市場是安全監控領域(圖2),例如人流偵測、人臉識別,或是對敏感區域劃設虛擬圍籬等。但對工業應用來說,這些方案除了適用于廠區的安全監控系統之外,像是生產線上的產品檢測、引導機器手臂作業等典型的機器視覺應用,很難採用這類ASIC方案來實現。至於微電子、半導體等級的自動光學檢測,這些ASIC方案就更難派上用場了。

圖2 安全監控的市場規模龐大,吸引眾多ASIC廠商為其開發AI演算法加速器方案。

對IC設計業者而言,針對少量多樣的工業市場開發ASIC產品,成本效益是最大的難題。因此,晶片業者的發展策略必然是利用安防產業所創造的經濟規模,向外拓展出部分工業或產業用嵌入式設備的應用市場。

近期英特爾跟IC設計新創公司耐能(Kneron),都分別與工業電腦業者結盟,試圖將NPU與加速器推進智慧零售應用,因為智慧零售的需求跟安防基本上相通,不需要太大幅度的設計修改。但有工業電腦業者認為,在未來三到五年內,NPU或ASIC加速器方案在產業領域的應用,大概也只會到這裡為止,要進一步跨入變異性更高的工業應用,機會應該不大。

FPGA限制最少 考驗設備商IC設計功力

過去幾年,有鑒於人工智慧需求興起,FPGA業者在自家開發工具跟協力廠商生態系夥伴的建構上投入不少心力,成果也陸續展現。在資料中心端,利用FPGA來加速神經網路或深度學習演算法,已經是很多網路巨擘所實行的作法,因此,FPGA廠商自然也將下一步發展重心放到邊緣運算上。

對工業應用來說,FPGA是個很理想的選擇。由於工業應用向來是個少量多樣的市場,很難期待晶片供應商針對工業設備業者的需求,推出對應的晶片解決方案。也因為這個緣故,某些研發實力較強的工業設備業者,一直都是靠FPGA來實現自己所需要的晶片功能。最典型的例子就是高階的運動控制設備,或是某些需要大量I/O的控制器。

而在人工智慧從雲端走向邊緣的過程中,工業設備製造商自然不會忽視用FPGA來實現人工智慧這個選項。且在FPGA業者陸續推出機器學習開發環境,協力廠商業者的軟體智財也逐漸到位後,利用FPGA在嵌入式裝置上執行人工智慧應用,困難度已經相對降低。不過,就和利用GPU平台上的協力廠商資源一樣,設備開發商如果要使用協力廠商開發的演算法,通常會有額外的授權費用產生。

FPGA最大的優勢在於硬體功能的配置非常彈性,如果工業設備開發商已經有自己的人工智慧演算法,開發團隊可以利用FPGA實現對應的硬體加速器,達到最高程度的系統設計優化。但相對來說,當軟體設計有所更動時,硬體可能也需要做對應的調整,而這個時間是相對耗時的。

事實上,要把FPGA的潛力發揮到淋漓盡致,開發團隊必須相當熟悉積體電路的設計作業,諸如電路合成、時序收斂、繞線佈局等。雖然FPGA供應商的開發工具多半已經可以將相關作業自動化,但要進一步將設計優化,設計人員還是需要具備相關知識,而且為了因應軟體設計反覆運算,硬體也要跟著頻繁反覆運算,這是很花時間的。

因此,比較理想的開發流程還是先從GPU開始,等軟體設計反覆運算到相對穩定的階段,再針對已經穩定的軟體做對應的硬體加速設計。而非直接從一開始就用FPGA平台做軟硬體同步開發。

訓練資料集建置不易 AI走進工業應用還需醞釀

雖然各晶片大廠對於人工智慧走向邊緣的發展趨勢都有很高的期待,並已推出對應的邊緣運算解決方案,但對工業應用來說,最麻煩的問題不是缺乏硬體或演算法,而是缺乏訓練用的資料集。

不像一般針對消費性或安防領域的人工智慧應用開發商,可以用低廉的人力成本找來大量資料標籤員,快速完成訓練資料集的建置。工業用的人工智慧應用處理的是各種專業領域的資料,一般人無法判讀這些資料。

以藉由機器視覺來檢視金屬加工件這項應用為例,工業相機可以輕而易舉地取得成千上萬張金屬加工件的影像,但這些影像對一般人來說看起來都差不多,只有業內專家能夠看出其中的些微差異,進而區別出良品跟不良品。

高品質的訓練資料集才能確保人工智慧判斷的準確性,但工業領域的高品質資料集不容易建置,是目前工業設備業者、乃至有心導入人工智慧的製造業者所共同面臨的問題。而且,由於這些資料往往涉及營業秘密,因此只能用內部有限的專家人力來建置資料集,無法外包給外部專家,這使得資料集的建置工作需要耗費更長的時間。

綜合多家國際工業設備巨擘與大型製造業者的觀點,即便目前人工智慧軟硬體方案已經比過去成熟許多,但相關廠家現階段大多還停留在研發前期或中期階段,僅有少數動作比較快的業者,已經開始在實驗產線上進行測試。因此,工業領域普遍導入人工智慧,可能還需要2~3年時間醞釀。

好還要更好 Arm持續提升CPU效能滿足5G需求

5G高速、低延遲、大頻寬的特性,使無線傳輸的頻寬持續加大,資料量也跟著與日俱增,且邊緣的運算需求也不斷提高。因此Arm積極布局5G相關領域,透過提供更快速的CPU處理,提升使用者體驗。

Arm市場行銷副總裁Ian Smythe表示,對於運算密集的機器學習(ML)、擴增實境(AR)與其它在裝置上全新與新興的使用案例,5G都是不可或缺的需求。它會帶來更快的速度、超高的流量(介於5~20 Gbps)、全新的觀賞體驗、8K解析的影片串流,以及360度影像。

Ian也提到,5G就緒是一個前所未有的機會,而目前最重要的就是要能夠支援各種新興案例和服務類型所需的龐大運算量。5G的推出可能會帶來許多系統設計挑戰,這些挑戰將集中在三個方面,尺寸、功耗和效能。如果產品不符合標準,5G的機會將是多餘的。

然而5G的速度提升對於設備的功率和散熱將是一大挑戰,且設備和電池越來越薄,因此設計也更加困難。此外,5G更高的傳輸量將挑戰整個系統運算的極限。因為5G有無限的潛力,但仍然有許多未知的挑戰。但Ian表示,客戶對運算量的需求是永無止境的,而Arm的目標就是提供更快的CPU處理效能,讓客戶可以有良好的使用體驗。

為此,Arm推出了Cortex-A77,Cortex-A77在提供效能與效率提升的同時,全新CPU也延續當初Cortex-A76所實現的各種功能。把時光回溯到2018年,Cortex-A76超過20小時的電池續航力是當時的關鍵功能,而Cortex-A77也將持續此一趨勢。這意謂著與Cortex-A76一樣能提供多日的電源續航力,且效能更提升。

Ian透露,Arm也計劃於2020年推出一個效能更好的產品。由於人們對運算量與傳輸速度的要求不斷上升,Arm承諾將不斷提升CPU運算效能,迎接無論是5G或是其他未來的挑戰。

手勢/心跳皆可偵測 140GHz MIMO雷達超有感

比利時奈米電子和數位科技研究與創新中心imec,發布以28奈米CMOS技術打造的140GHz MIMO雷達單晶片,能在兼顧小尺寸、低成本、低功耗前提下,實現更高解析度與靈敏度,可望進一步擴展毫米波雷達在手勢辨識、生命體徵監測與細微運動偵測等領域的應用版圖。

隨著5G與自駕車發展日益升溫,毫米波技術的應用潛力逐漸受到產業界重視,相關研發活動與投資也不斷增加,除了聚焦在5G高頻通訊與汽車駕駛輔助系統(ADAS)的雷達應用外,利用毫米波雷達實現更多元的感測應用,亦是另一個重要發展方向。

針對非汽車ADAS的雷達感測應用,目前市場上以60GHz毫米波雷達方案為主,而imec此次所發表的140GHz毫米波雷達單晶片,則是另一突破性的技術進展。

imec研發團隊負責人Andy Dewilde說明,imec長久以來在CMOS技術的開發與多天線整合設計上擁有相當厚實的能力與經驗,因此能在一個外觀尺寸只有幾平方公分的完整MIMO雷達系統下,實現1.5公分的精準解析度。而更好的距離解析度性能,可開啟更多新的應用機會,這是該公司140GHz雷達系統單晶片重要的差異化特色之一。

Dewilde進一步談到,使用140GHz頻段的另一個明顯好處是,電磁波波長更小,僅2.1毫米,換言之,天線也就可以做得很小,因而imec僅透過28奈米Bulk CMOS製程技術,即可將天線直接整合至單晶片中,毋須使用昂貴的天線模組或外部天線,達到更高整合度與小尺寸設計,且未來也可輕易藉由大量量產來達到降低成本目標。

不僅如此,高頻毫米波波長小的特性,也可偵測到更小的位移變異,如細微的臉部表情變化與皮膚運動,能顯著提升位移靈敏度,有助於生命體徵偵測等應用,因此該雷達是實現車內生命體徵監測系統極佳的方案,可促成非接觸式駕駛狀況追蹤,例如偵測駕駛有沒有打瞌睡、壓力狀況是否異常,或者預防因急性健康危害如心臟疾病或癲癇發作。另一個可能應用,是利用動作和生命體徵偵測來監測小孩狀況,例如當兒童不小心被留在車內時發出警報,即使當下是嬰兒蓋著毯子睡覺,該雷達感測器也可發揮作用。

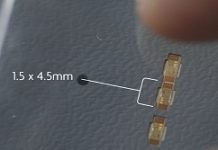

除了140GHz高頻毫米波頻段所帶來的技術優勢外,imec也在該款雷達晶片中,加入MIMO多天線配置與機器學習能力,從而打造直覺簡單的人機互動介面。imec荷蘭雷達專案研發經理Barend van Liempd指出,藉由加入機器學習能力,imec已證明雷達基於都卜勒(Doppler)訊息來偵測和分類細微動作的可行性,這將開啟新的應用機會,如實現直覺的手勢辨識人機互動。以擴增實境/虛擬實境(AR/VR)應用來說,新的雷達方案就可支援與虛擬物件的直覺式互動,手勢辨識還可以實現直覺的裝置控制,與現今語音控制或智慧觸控螢幕的人機介面相輔相成。

據了解,imec所研發的140GHz雷達晶片方案主要適用於室內的應用,操作範圍可達10公尺,且尺寸極為小巧,單一晶片大小僅1.5x4.5mm,可在幾乎各種裝置中被無形地整合,諸如筆電、智慧手機或螢幕邊框。

為了增加數據的豐富性和空間資訊,imec已著手開發下一代採用4x4的MIMO雷達系統,以及新的雷達晶片。Dewilde指出,目前的140GHz雷達系統原型,採用的是2x2 MIMO設計,所以只能做一個方向的角度偵測,下一個系統,會使用新版晶片,預計研發4x4 MIMO,有更多天線,以達到3D偵測。

imec研發團隊負責人Andy Dewilde利用imec 140GHz雷達系統原型,展示手勢辨識應用。

萬物智慧化驅動半導體成長 EDA工具角色更吃重

新思科技(Synopsys)近日舉辦SNUG Taiwan 2019研討會,主題涵蓋以EDA縮短晶片設計時程與AIoT兩大議題。此外,該研討會還邀請了20家半導體廠商發表設計研究心得,並舉行多達40餘場IC設計相關技術發展的專題講座。新思也透過這次研討會說明其最新的Fusion Design Platform、TestMAX、機器學習(Machine Learning)與硬體模擬(Emulation)等解決方案。

新思科技設計事業群聯席總經理Deirdre Hanford表示,各種智慧應用的蓬勃發展,是帶動半導體產業成長的主要動力來源,但這個趨勢也使得晶片設計變得更加複雜,晶片開發者必須要有新的設計工具輔助,才能趕得上客戶要求的產品上市時程。

為此,新思推出了融合設計平台(Fusion Design Platform),並在推出的第一年即達到超過100個產品投片(Tapeout),寫下7奈米製程的重要里程碑。該平台協助客戶提升20%的設計結果品質(Quality-of-Results,QoR),並達到超過2倍的結果效率(Time-to-Results,TTR)。融合設計平台整合新思科技的數位設計工具,並重新定義傳統設計工具的範疇,包括共享引擎、用於邏輯及物理表現(Logical and physical representation)的單一數據模型。

此外,新思也與安謀國際(Arm)擴展合作關係,推出支援新思Fusion Compiler解決方案的QuickStart實作套件(QIK)。這是一個從RTL到GDSII完全整合的實作系統,可讓採用Arm架構的SoC設計達到最快速的結果效率,並改善功耗、效能與晶片面積,能快速實現具備安謀最新核心架構的高度差異化產品。這項合作已讓採用內含Cortex-A76與Neoverse N1處理器的SoC先期用戶,成功實現投片。

而為了協助推動AIoT晶片研發,新思在台灣也已經與台灣大學、清華大學、交通大學、中央大學以及成功大學等五所頂尖大學共同啟動「AIoT設計實驗室」產學合作計劃,捐贈各校晶片開發核心套件與人工智慧/機器學習教材(AI/Machine learning),以誘發學界對於AIoT設計的強大研發能量,並培育先進半導體設計人才。

新思科技一直是台灣半導體產業發展的重要策略夥伴,持續引進創新技術協助客戶突破研發瓶頸,並推動產官學研緊密合作,除了AIoT設計實驗室合作計畫,新思科技也積極參與科技部「半導體射月計畫」、「AI創新研究中心」以及「博士創新之星計畫」,還捐贈資策會「國際微電子學程」,並參與教育部「國際積體電路電腦輔助設計軟體製作競賽(ICCAD Contest)」之平台開發組競賽等產學交流計畫等,提升台灣半導體設計的研發能量。